探秘深度学习:神经网络、卷积神经网络和循环神经网络

2023/5/5 23:22:07

本文主要是介绍探秘深度学习:神经网络、卷积神经网络和循环神经网络,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

深度学习是一种人工智能技术,它的主要目标是让计算机能够像人类一样地学习和解决问题。在过去的几年中,深度学习已经成为了人工智能领域中最受关注的技术之一。本文将详细介绍深度学习的知识点,包括神经网络、卷积神经网络、循环神经网络等。

神经网络

神经网络是深度学习的核心组成部分,也是最基础的模型。它通过多层次的非线性转换,从输入数据中提取出高级别的特征表示,然后用这些特征进行分类或回归等任务。神经网络的基本组件是神经元,每个神经元都有一定数量的输入和输出,它通过对输入信号进行加权求和并加上一个偏置项,再通过激活函数进行处理,最终产生一个输出结果。

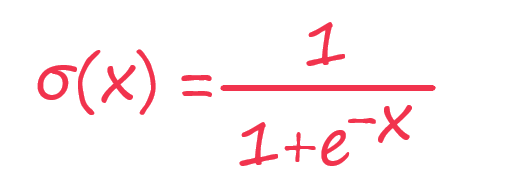

在神经网络中,常见的激活函数包括sigmoid函数、ReLU函数和tanh函数等。其中,sigmoid函数的表达式为:

ReLU函数的表达式为:

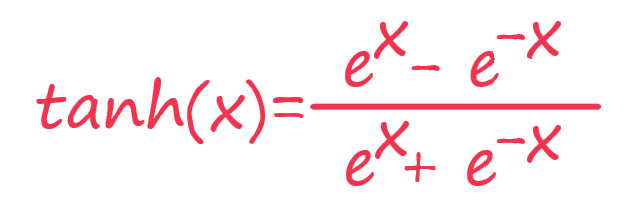

tanh函数的表达式为:

神经网络的训练过程通常采用反向传播算法,它可以有效地计算每个神经元对模型误差的贡献,并将误差反向传播给前面的神经元,以更新神经元的权重和偏置项,从而不断优化模型。

卷积神经网络

卷积神经网络是深度学习中应用最广泛的模型之一。它通过卷积层、池化层和全连接层等组件来提取图像、音频等数据中的特征,并用这些特征进行分类、目标检测、语音识别等任务。

卷积神经网络中的卷积层通过使用卷积核对输入数据进行卷积操作,得到一个新的特征图。卷积核可以看作是一种特殊的滤波器,它在输入数据上进行滑动,从而提取出不同尺寸的特征。池化层则通过对特征图进行降采样操作,减少特征图的大小和参数量,从而降低模型的复杂度。通常采用的池化方式有最大池化和平均池化两种。

卷积神经网络的训练过程也采用反向传播算法,但与普通神经网络不同的是,它要求反向传播到卷积层和池化层,并更新这些组件中的参数。

循环神经网络

循环神经网络是一种涉及时间序列的深度学习模型。它通过使用循环单元来处理时间序列数据,可以有效地捕捉时间序列数据中的长期依赖关系,从而在语音识别、自然语言处理等任务中取得优异的效果。

循环神经网络的核心是循环单元,它能够存储和利用之前的信息。在每个时间步骤中,输入数据和上一个时间步骤的输出会被送入循环单元进行计算,得到当前时间步骤的输出结果。最常见的循环单元是长短期记忆网络(LSTM)和门控循环单元(GRU)。其中,LSTM将当前时间步骤的输入和上一个时间步骤的输出分别传入三个门,它们分别控制着信息的遗忘、更新和输出,从而保证了模型对于长序列的记忆和提取。

循环神经网络的训练过程也采用反向传播算法,但由于循环单元的存在,其计算过程相对复杂。目前,常用的训练方法包括随时间反向传播算法(BPTT)和时序反向传播算法(TBPTT)。

总结

本文介绍了深度学习中的三种主要模型:神经网络、卷积神经网络和循环神经网络。这些模型通过不同的组件和算法来提取输入数据中的特征,并用这些特征进行分类、目标检测、语音识别等任务。深度学习技术已经在许多领域内取得了重大的突破,未来也将继续发展和应用。

这篇关于探秘深度学习:神经网络、卷积神经网络和循环神经网络的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

- 2024-12-24酒店香薰厂家:创造独特客户体验

- 2024-12-22程序员出海做 AI 工具:如何用 similarweb 找到最佳流量渠道?

- 2024-12-20自建AI入门:生成模型介绍——GAN和VAE浅析

- 2024-12-20游戏引擎的进化史——从手工编码到超真实画面和人工智能

- 2024-12-20利用大型语言模型构建文本中的知识图谱:从文本到结构化数据的转换指南

- 2024-12-20揭秘百年人工智能:从深度学习到可解释AI

- 2024-12-20复杂RAG(检索增强生成)的入门介绍

- 2024-12-20基于大型语言模型的积木堆叠任务研究

- 2024-12-20从原型到生产:提升大型语言模型准确性的实战经验

- 2024-12-20啥是大模型1