LLM运维:计算大规模语言模型在GPU上的显存需求,以实现高效部署

2024/10/12 21:02:58

本文主要是介绍LLM运维:计算大规模语言模型在GPU上的显存需求,以实现高效部署,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

随着大型语言模型(LLMs)变得越来越复杂,理解运行这些模型所需的 GPU 内存变得至关重要。不论是 LLaMA 还是 GPT,所需的 VRAM(视频内存)量将显著影响您的硬件选择。在本文中,我们将分解计算所需 GPU 内存的关键公式,以支持 LLM 的运行,并通过一些实际示例进行说明。

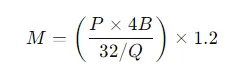

主要的公式要确定特定模型所需的GPU内存,可以使用以下公式,

公式:

- M 表示所需的 GPU 内存,单位为千兆字节(GB)。

- P 表示模型中的参数数量。例如,一个 7B 模型有 70 亿个参数(即70亿)。

- 4B 表示每个参数通常占4字节。

- 32 表示4字节中的位数(即32位)。

- Q 表示加载模型所用的位数(例如,如16位、8位或4位)。

- 1.2 用于超出参数本身的额外20%内存开销。

我们来看看一个具有70亿参数(70B)的LLaMA模型的实例。

第一步:计算16位精度的数值

假设我们以半精度(FP16)加载模型时,这在许多应用程序中很常见。

对于这种情况,模型需要168 GB的VRAM(显存)。这意味着一个80GB的A100 GPU(图形处理器)不太够用,但两个这样的GPU就能胜任了。

量化如何有帮助:量化将精度从32位或16位浮点数减少到较低位的整数,如8位或甚至低至4位。这种精度的降低减少了所需的VRAM和计算能力的消耗,使得在资源更有限的设备上部署大型模型成为可能。

虽然8位量化通常已经足够应对大多数任务,4位量化则能进一步降低内存使用量,不过,它可能会对模型性能带来明显的影响,这要视具体应用场景而定。

(我这种情况该选哪张巫师卡比较好?)

结论。

在为大型语言模型服务时,计算所需的GPU内存对于优化性能和资源分配至关重要。通过理解并应用内存计算公式,并利用如量化等技术,您可以确保您的硬件配置既高效又能应对最苛刻的大型语言模型。

不论你是在部署单个大型模型还是管理多个大型语言模型,了解如何计算 GPU 内存需求将帮助你做出明智的决策,并从而最大限度地利用你的硬件资源。

这篇关于LLM运维:计算大规模语言模型在GPU上的显存需求,以实现高效部署的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

- 2024-11-15Tailwind开发入门教程:从零开始搭建第一个项目

- 2024-11-14Emotion教程:新手入门必备指南

- 2024-11-14音频生成的秘密武器:扩散模型在音乐创作中的应用

- 2024-11-14从数据科学家到AI开发者:2023年构建生成式AI网站应用的经验谈

- 2024-11-14基于AI的智能调试助手创业点子:用代码样例打造你的调试神器!

- 2024-11-14受控组件学习:从入门到初步掌握

- 2024-11-14Emotion学习入门指南

- 2024-11-14Emotion学习入门指南

- 2024-11-14获取参数学习:初学者指南

- 2024-11-14受控组件学习:从入门到实践