Llama3 来了!– 要点

2024/10/12 21:03:00

本文主要是介绍Llama3 来了!– 要点,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

你需要了解关于最新最前沿的开放基础模型的哪些信息

所以今年最期待的模型终于出来了,来自Meta的AI团队的#llama3,等它值不值得呢?

Meta发布了Meta Llama 3,这是他们开源大型语言模型系列中的最新成员,包括80亿和70亿参数的模型。

- 新的分词器:Llama 3 使用了一个词汇量为 128K 的分词器,效率更高,与 Llama 2 相比,可以减少多达 15% 的分词。

- 分组查询注意力:在所有模型中实施,使得较小的模型比 Llama 2 更有能力,后者仅在其最大的模型中使用。

- 预训练使用了 15 万亿个分词,其中 95% 是英文。

- 同时在 16K GPU 上训练,开发了新的工具来管理 GPU 利用率。希望他们能发布,因为 GPU 利用率是我见过的微调中最大的挑战。

- Llama 2 的有趣用法:在数据质量领域中,它展示了 LLM 的有趣应用场景。

- 新的微调方法:在指令集中结合推理跟踪和偏好排序,目的是减少模型幻觉和错误率。

- 新库:TorchTune,一个用于 LLM 的 PyTorch 原生库,用于编写、微调和实验,提供了内存高效且可编程的训练配方。

- 责任:Meta 强调负责任的人工智能开发,提供了诸如 Llama Guard 2 和 Code Shield 之类的信任和安全工具。

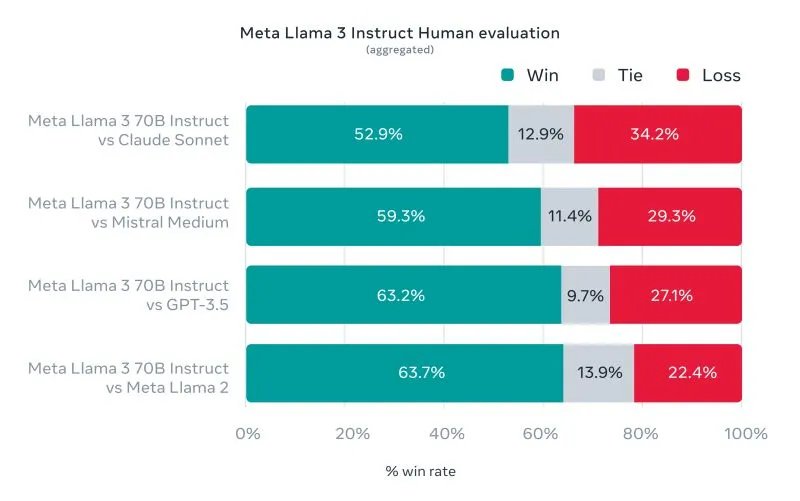

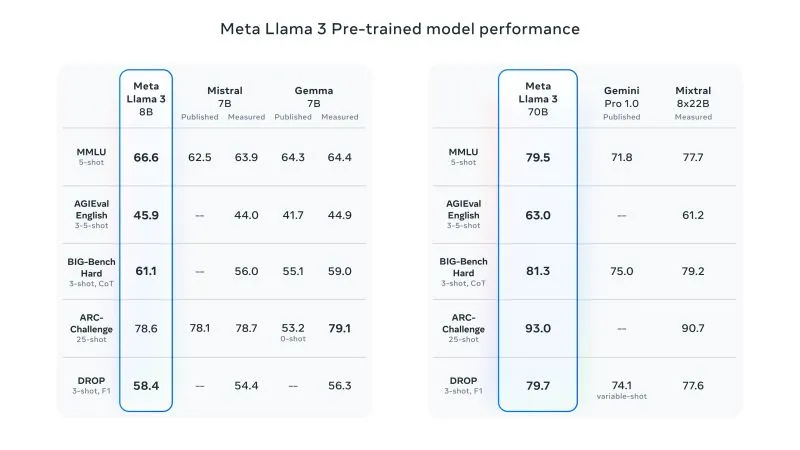

- 性能:Llama 3 在性能上设立了新标准,拥有改进的推理能力,并在行业基准测试中取得了优异的成绩。我看到的详细基准测试是与 Claude 而不是 GPT4 的比较。

虽然它没有与GPT4进行详细的比较,也没有链接到研究论文,但它暗示将会有更多东西即将推出,可能是4000亿参数的模型。这款4000亿参数模型的早期测试结果可能成为生成式AI领域的下一个重大突破。

最酷的是,#llama 实际上是开放的,并可以在如 #huggingface 和 #watsonx 这样的开放平台上使用。

这篇关于Llama3 来了!– 要点的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

- 2024-12-20自建AI入门:生成模型介绍——GAN和VAE浅析

- 2024-12-20游戏引擎的进化史——从手工编码到超真实画面和人工智能

- 2024-12-20利用大型语言模型构建文本中的知识图谱:从文本到结构化数据的转换指南

- 2024-12-20揭秘百年人工智能:从深度学习到可解释AI

- 2024-12-20复杂RAG(检索增强生成)的入门介绍

- 2024-12-20基于大型语言模型的积木堆叠任务研究

- 2024-12-20从原型到生产:提升大型语言模型准确性的实战经验

- 2024-12-20啥是大模型1

- 2024-12-20英特尔的 Lunar Lake 计划:一场未竟的承诺

- 2024-12-20如何在本地使用Phi-4 GGUF模型:快速入门指南