OpenAI提示缓存

2024/10/21 21:03:30

本文主要是介绍OpenAI提示缓存,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

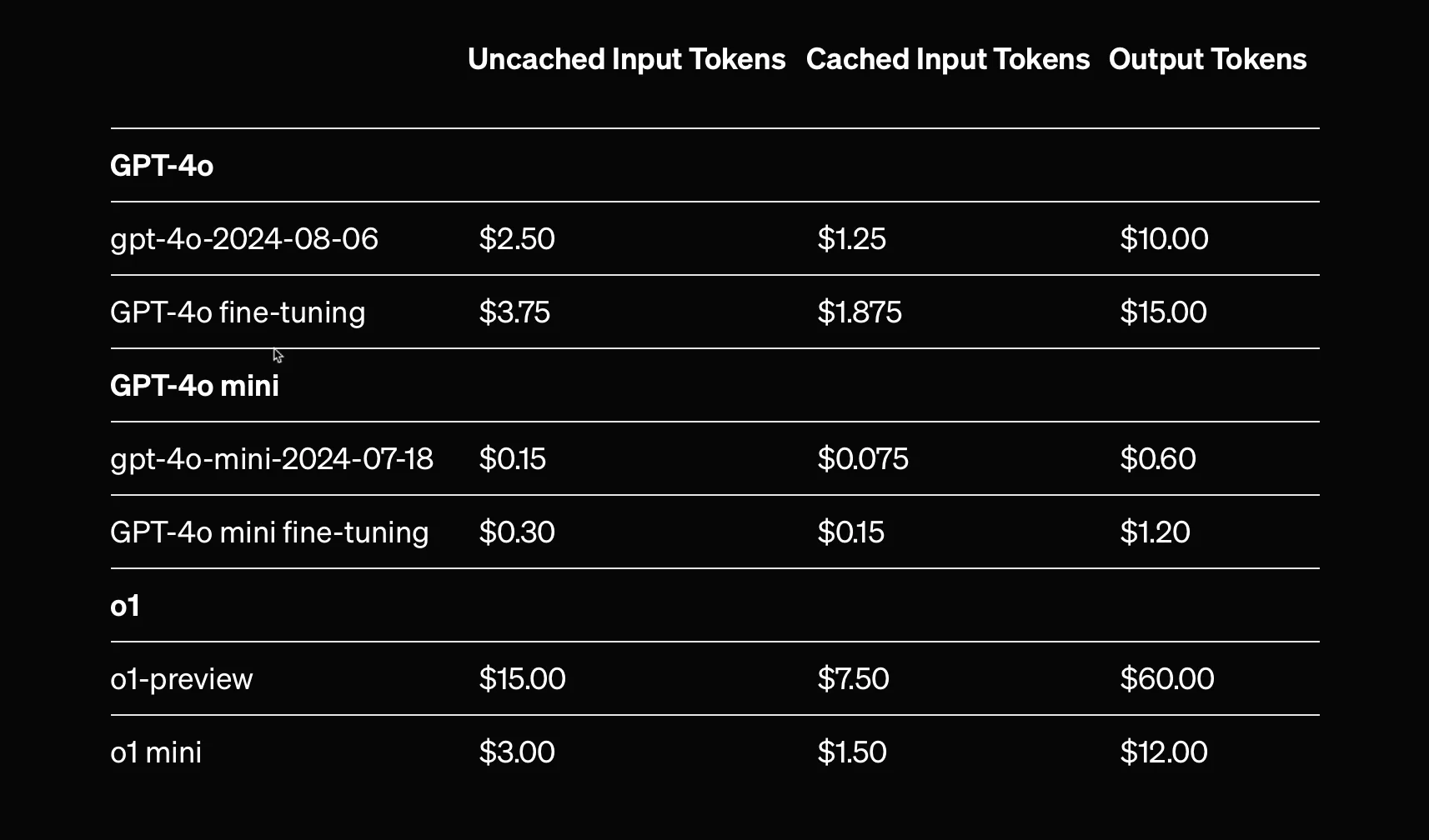

默认情况下,最新的GPT-4o系列和GPT-4o mini系列(包括这些模型的微调版本)启用了缓存提示的功能。

此功能提供缓存的提示内容,费用比标准提示低,为频繁重复的查询提供了更高效的选择,从而降低成本。

zh: 来源页面

缓存通常在无操作5到10分钟后清理,并在一小时后过期删除。

这项功能旨在帮助开发人员在管理性能、成本和延迟的情况下有效扩展应用程序规模。

{

"usage": {

"prompt_tokens": 36,

"completion_tokens": 300,

"total_tokens": 336,

"prompt_tokens_details": {

"cached_tokens": 0

},

"completion_tokens_details": {

"reasoning_tokens": 0

}

}

}

翻译为:

{

"使用情况": {

"提示令牌数": 36,

"完成令牌数": 300,

"总令牌数": 336,

"提示令牌详情": {

"缓存令牌": 0

},

"完成令牌详情": {

"推理令牌": 0

}

}

}

是的,将缓存等功能卸载给模型时,可能会变得过于依赖该模型。

过度依赖模型可能会减少对数据管理的控制,限制根据应用需求调整缓存策略的灵活性。

此外,模型缓存实现的任何变更或限制也可能影响到系统的整体性能。

所以,平衡使用内置功能和保持对关键组件的控制权非常重要。

提示缓存和提示播种在AI模型的应用中起着不同的作用。

提示缓存功能存储常用的提示,以加快访问速度,减少重复查询的延迟时间。

给模型设置初始参数或初始值,但是通过特定的参数或初始值来初始化模型,以确保类似提示下的输出保持一致。

实际上,Prompt 缓存技术通过复用缓存的提示来加快响应速度,而初始化旨在通过设定初始状态来保持不同运行间结果的一致性。

目前,OpenAI的API没有提供特定功能来直接监控提示的缓存情况。

缓存行为通常由 OpenAI 在后台进行管理,因此开发人员无法直接访问缓存监控界面。

开发者可以通过追踪响应时间或查看日志,间接监控缓存的有效性。如果重复的请求更快处理,那就意味着它们已被缓存。

对于需要精确工具或更新的情况,建议查看OpenAI的API文档和相关支持资源。

OpenAI的缓存提示功能引发了用户对过度依赖模型以及将重要功能转移给模型的担忧。

这种变化可能会造成对操作细节的控制不足,从而可能影响用户体验。

然而,缓存提示最大的好处在于它为已经使用该服务的用户自动带来的好处,使他们无需额外努力就能使用该功能。

尽管有挑战,总体来说提升性能的潜力依然很大。

首席传道者注:此处译为“首席传道者”,在AI领域可能不常见,具体指首席布道师或首席传道师,即在技术领域负责推广和传播技术理念的人。@Kore.ai _| 我热衷于探索人工智能与语言的交叉领域。从语言模型、AI代理到代理应用程序、开发框架及以数据为中心的生产力工具,我分享关于这些技术如何塑造未来的见解和想法。

(https://www.cobusgreyling.com/?source=post_page-----10c79f7cd1f1--------------------------------)

访问有关OpenAI API缓存提示的页面: https://openai.com/index/api-prompt-caching/

这篇关于OpenAI提示缓存的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

- 2024-12-22程序员出海做 AI 工具:如何用 similarweb 找到最佳流量渠道?

- 2024-12-20自建AI入门:生成模型介绍——GAN和VAE浅析

- 2024-12-20游戏引擎的进化史——从手工编码到超真实画面和人工智能

- 2024-12-20利用大型语言模型构建文本中的知识图谱:从文本到结构化数据的转换指南

- 2024-12-20揭秘百年人工智能:从深度学习到可解释AI

- 2024-12-20复杂RAG(检索增强生成)的入门介绍

- 2024-12-20基于大型语言模型的积木堆叠任务研究

- 2024-12-20从原型到生产:提升大型语言模型准确性的实战经验

- 2024-12-20啥是大模型1

- 2024-12-20英特尔的 Lunar Lake 计划:一场未竟的承诺