CVPR 2024大会前瞻:视觉提示技术将颠覆计算机视觉,基础模型迎来重大变革

2024/10/25 21:03:19

本文主要是介绍CVPR 2024大会前瞻:视觉提示技术将颠覆计算机视觉,基础模型迎来重大变革,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

了解 CVPR 2024 上视觉提示技术的 5 项突破性进展,真的不容错过。

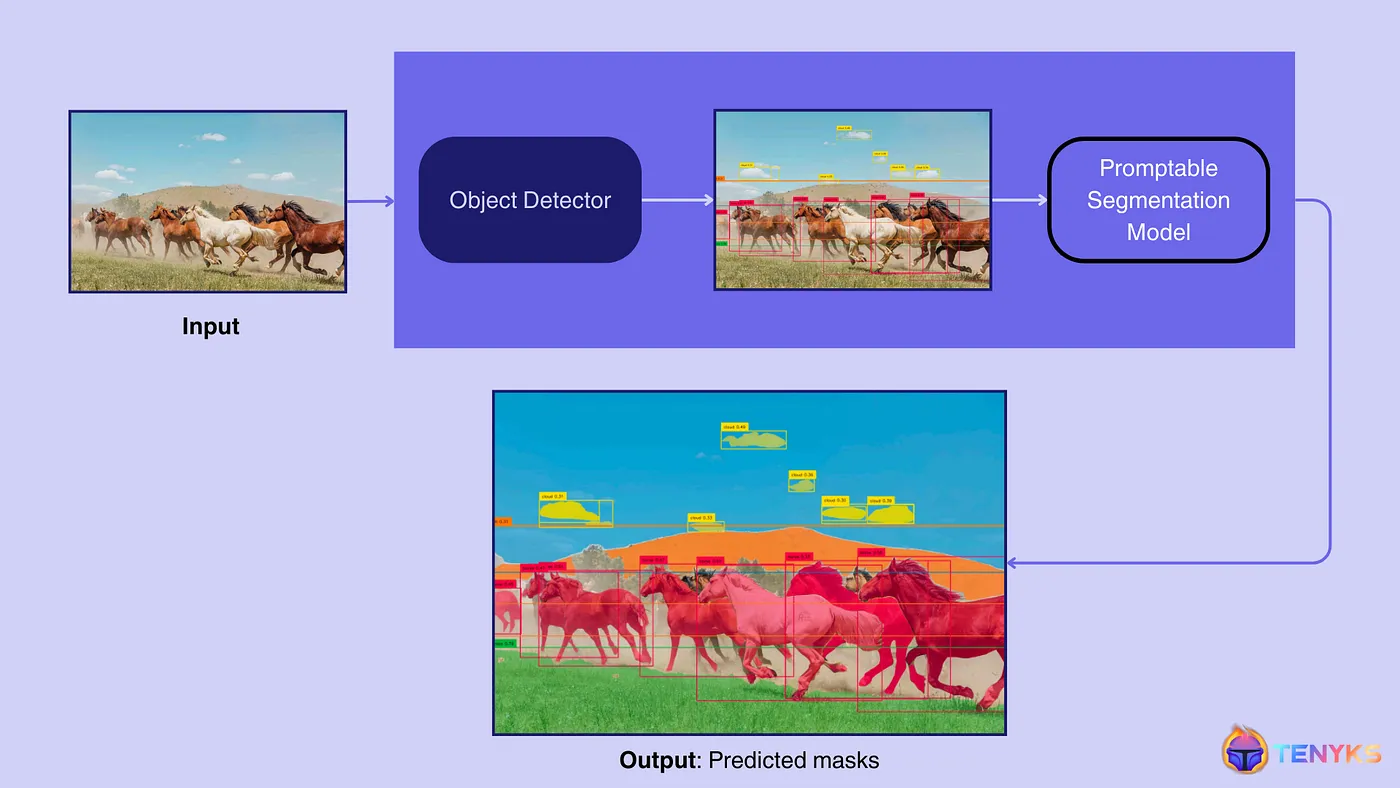

视觉提示在行动:一个视觉系统,利用预测作为提示信息,来激活可提示的模型。

TL;DR 🔥 5 项计算机视觉中的视觉提示技术进展

1. 图像理解:简单的视觉标记可以帮助基础模型更好地理解图像的特定部分。

2. 多模态大型语言模型 (MLLMs):利用场景图使多模态大型语言模型能够更好地描述图像,而无需额外的训练数据。

3. 基础模型:通过战略视觉提示改进视觉基础模型(例如,SAM)。

4. 改进泛化能力:教会AI快速识别新物体,同时记住基础知识。

5. 视觉提示与主动学习相结合:AI可以聪明地学习新的视觉任务,使用更少的例子,并且不忘记它已掌握的知识。

在这篇文章里,我们将探讨视觉提示技术,这种技术能让视觉模型适应新任务。

除了定义这种方法的同时,并从系统角度来说明可提示模型如何以重塑该领域的方式正在重塑该领域,我们还强调了CVPR上提出的五项最重要的视觉提示技术的进展。

🔥 你绝对猜不到 CVPR 2024 揭晓了什么!看看这里最精彩的内容,

- 图像和视频搜索及理解(RAG、多模态、嵌入等更多)。

- 不容错过的亮点 — 具身AI、生成式AI、基础模型和视频理解等。

🔥 快来看看 Segment Anything Model 2 (SAM 2)

- 🆕 SAM 2 + GPT-4o — 通过视觉引导进行级联基础模型技术 — 第一部分

“提示是一种人人都能使用的模型编辑工具”

Phillip Isola,AI研究员,创造了“视觉提示”这一概念 [1]

- 什么是视觉提示

- 从系统角度聊聊视觉提示

- CV 2024 上最引人注目的视觉提示进展

- 接下来会怎样

1.1 视觉提示的由来

视觉提示技术最早可以追溯到2001年发表的作品《图像类比》[2]中的研究,在该研究中,研究人员开发了一种通过示例来处理图像的策略,在这种策略中,需要提示和查询来获取响应。

在生成式AI时代,视觉提示(提示或指令)有哪些新之处?

- 提示是指让模型完成它们并非有意训练的任务。从技术上讲,提示使得预训练的模型能够适应未见过的数据分布。

- 提示在语言模型中[3]非常流行,比如大型预训练模型(如GPT-4)可以适应新的任务。

- 视觉提示[1]是指使大规模视觉模型能够执行(未见过的)视觉任务的过程。

为了理解视觉领域中的提示(prompting),可能需要区分提示与微调(一种标准的调整手段)。

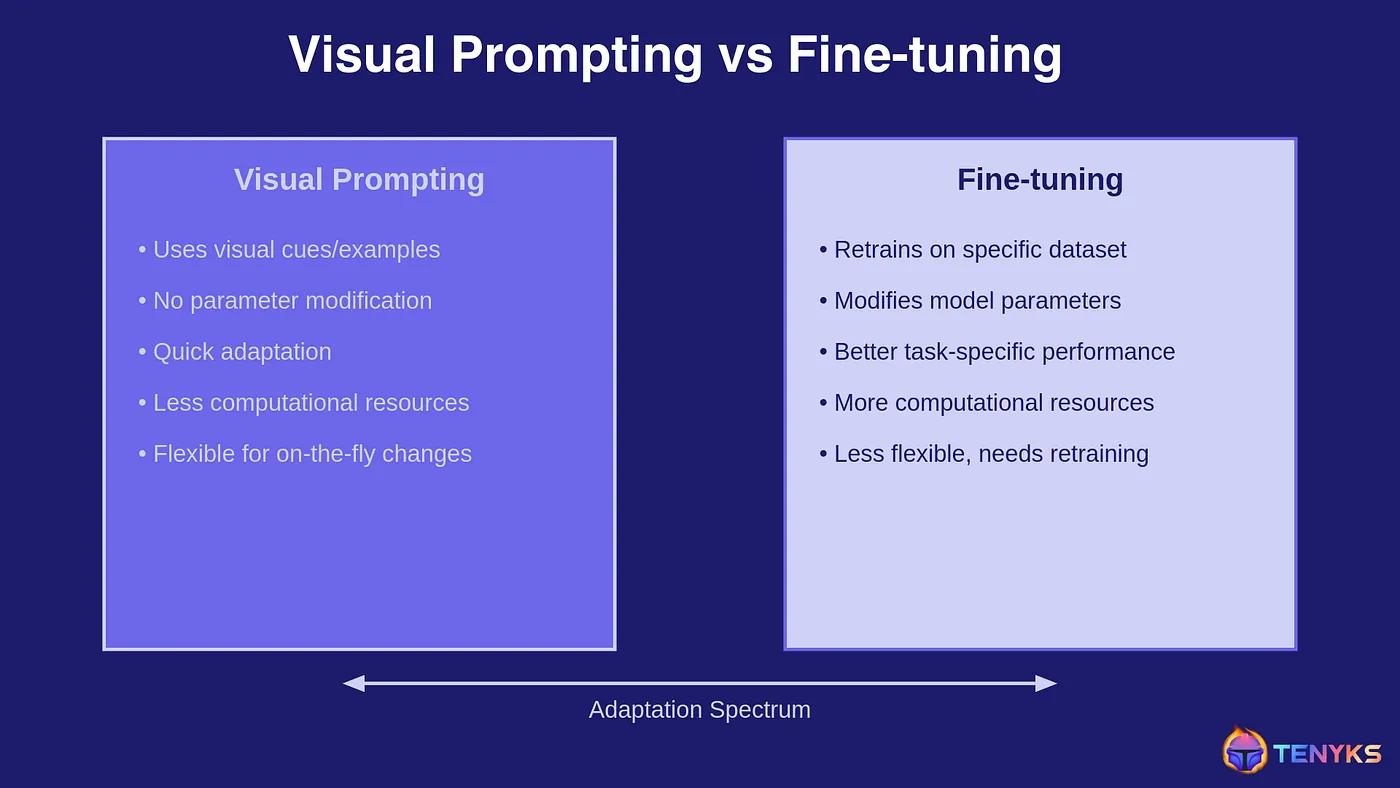

图1:视觉提示(Visual Prompting)与微调(Fine-tuning)的主要不同之处

图1说明了在用于计算机视觉的基础模型背景下,视觉提示与微调之间的关键区别。视觉提示使用视觉线索或示例来引导模型,而不调整其参数。这种方法不仅灵活,而且计算需求较低。相比之下,微调涉及在特定数据集上重新训练模型,通过调整参数来提升特定任务的性能,但需要更多的计算资源。

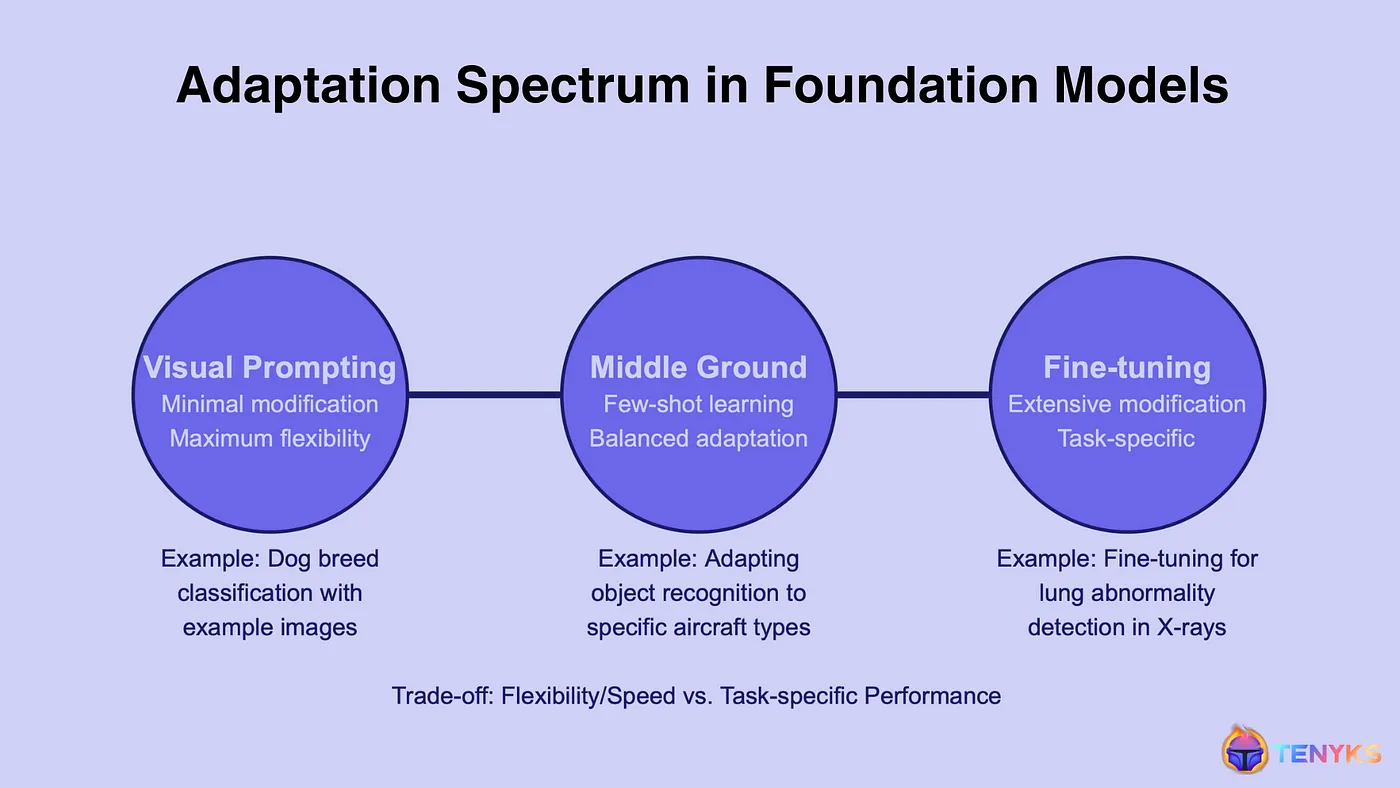

然而,这两种方法并不是非此即彼的选择。它们都代表了基础模型体系可能的适应方案的连续谱,如图所示。

图2. 可视化提示提供高度灵活性和快速适应

如上图所示,当需要灵活度和快速性时,采用视觉提示可能是应对这些应用(例如视觉搜索和检索、快速原型设计和实验)的最佳策略。

理解视觉提示法的优势的关键在于从系统角度来看这一技术,特别是在涉及多个阶段的视觉系统中。

一个可以接受提示的模型可以无缝地集成与其他系统,从而在更大的AI系统中执行特定任务时,能无缝对接。

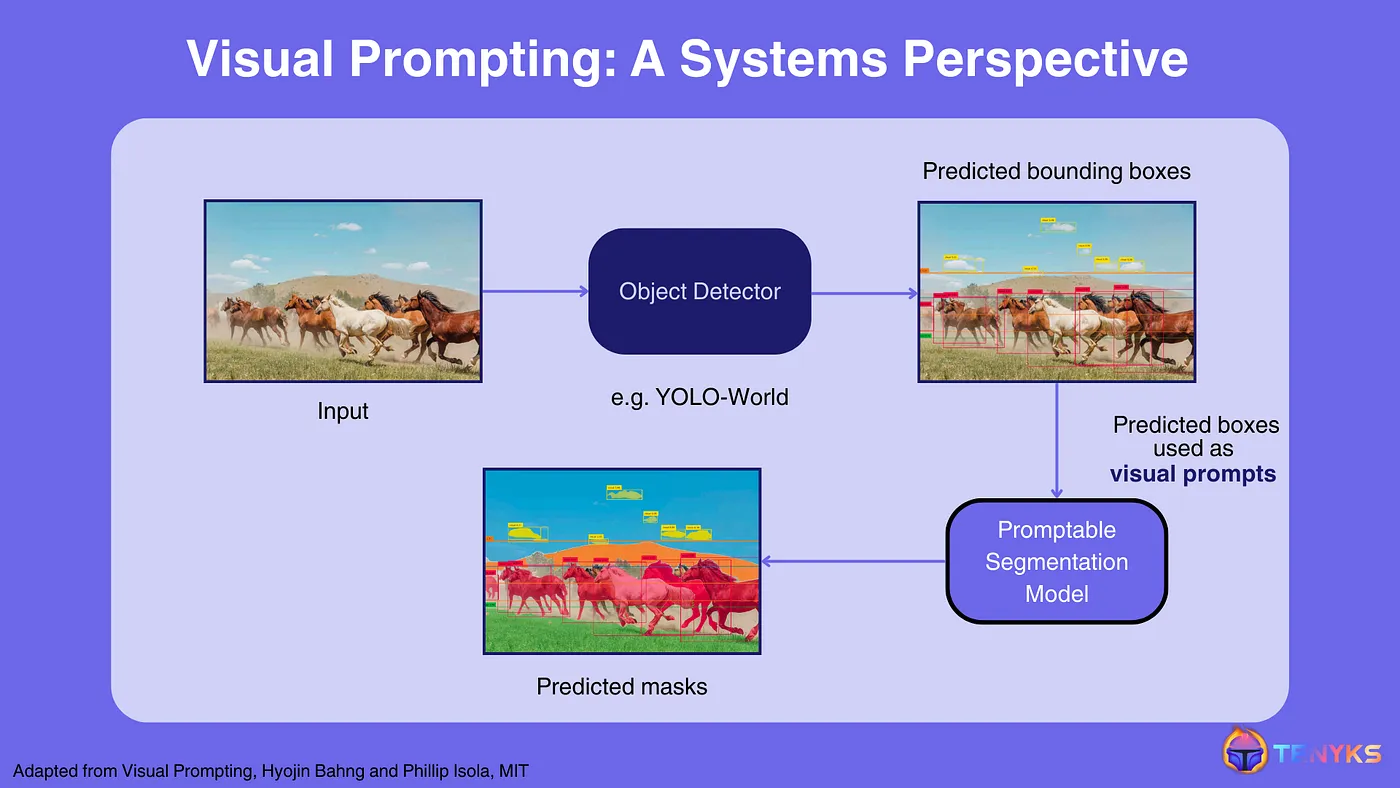

图3. 在多阶段视觉系统中集成视觉提示:基础模型(Foundation Model)SegmentAnything可以利用之前对象检测模型生成的视觉提示,来进行精确的图像分割(来源:文献4)。

图3-展示了将可被提示的基础模型作为更大系统组成部分的系统:

- 输入图片: 系统从一张输入图片开始,在这种情况下显示一群正在田野中奔跑的马。

- 目标检测: 输入图片通过目标检测器(例如,YOLO-World [6])进行处理。此步骤识别并定位图像中的目标,生成围绕检测到的目标的框。输出显示了围绕每匹马的框,以及天空中较小的云朵框。

- 分割: 检测到的框然后用作视觉提示,用于一个可提示的分割模型(例如,Segment Anything [5])。此模型为每个检测到的目标生成精确的掩码,从而实现图像更详细的分割效果。

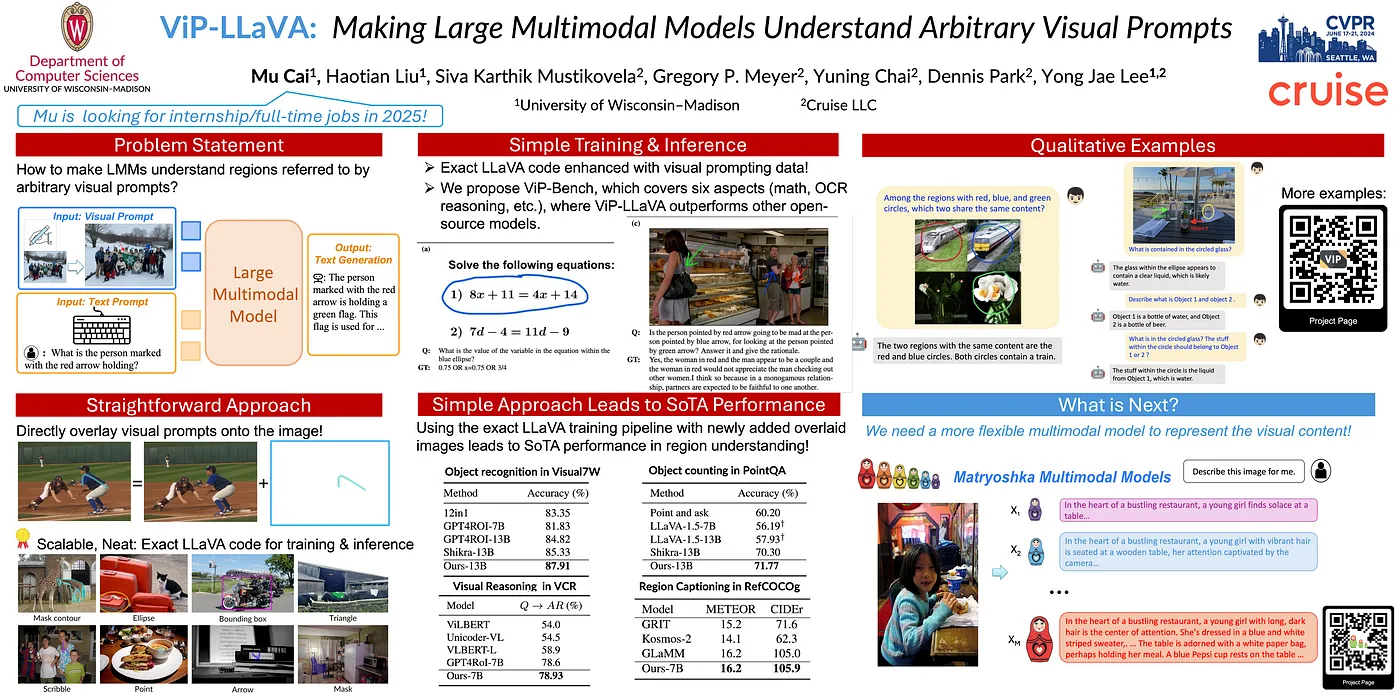

图4., CVPR 2024年ViP-LLaVA的海报

来自CVPR开放获取的论文原文:Cai_ViP-LLaVA_Making_Large_Multimodal_Models_Understand_Arbitrary_Visual_Prompts_CVPR_2024_paper.pdf

💻 试试它:https://vip-llava.github.io/

💡主要的新颖之处: 我们引入了一种多模态模型,能够解析任意形式的视觉提示,使用户可以通过在图像上标记自然提示(如“红色边框”,“指向的箭头”)来直观地与模型互动,而不需要复杂的区域编码。

可能的应用领域:

- a) 医疗成像:允许医疗专业人员在医学图像(如核磁共振成像、X光片)上标注特定区域,以实现更精准的诊断和分析目的。

- b) 电子商务产品搜索:使用户能够在产品图像中标记特定部分(例如,突出显示鞋跟),以查找类似商品或获取详细产品信息。

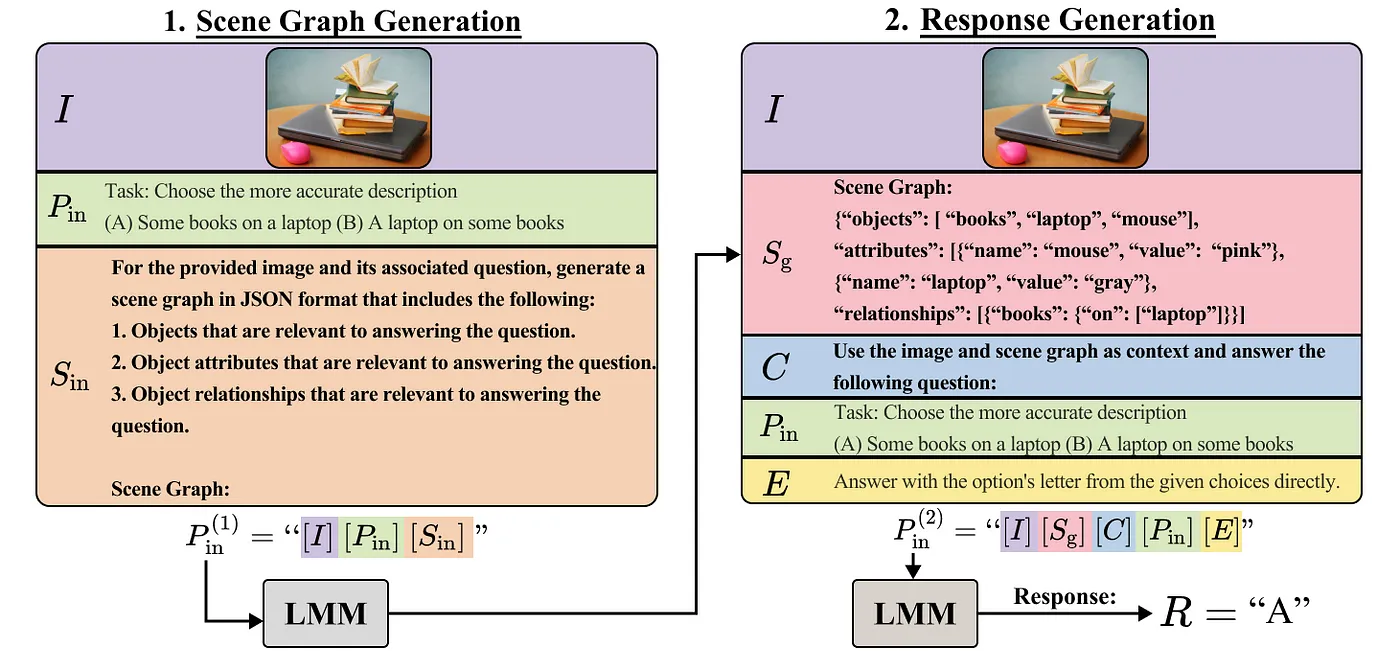

图5. CCoT完整提示示例:首先,用图像和任务提示生成场景图。然后,通过用图像、场景图和问题提示LMM来提取答案。

这篇: https://arxiv.org/pdf/2311.17076

💻试试这个:https://github.com/chancharikmitra/CCoT

💡 主要新颖点: 开发了组合思维链(CCoT)技术,这是一种两步零样本提示流程。首先,多模态大型语言模型(MLLM)根据任务提示将图像转化为场景图。然后,利用该场景图作为上下文,生成详细且准确的响应,利用组合信息的优势而无需标注数据或进一步微调。

可能的应用领域:

- a) 视觉问答:通过全面理解图像内容及其构成,准确回答有关图像的问题。

- b) 监控:识别图像中的物体并理解它们之间的关系,这对监控应用非常有帮助。

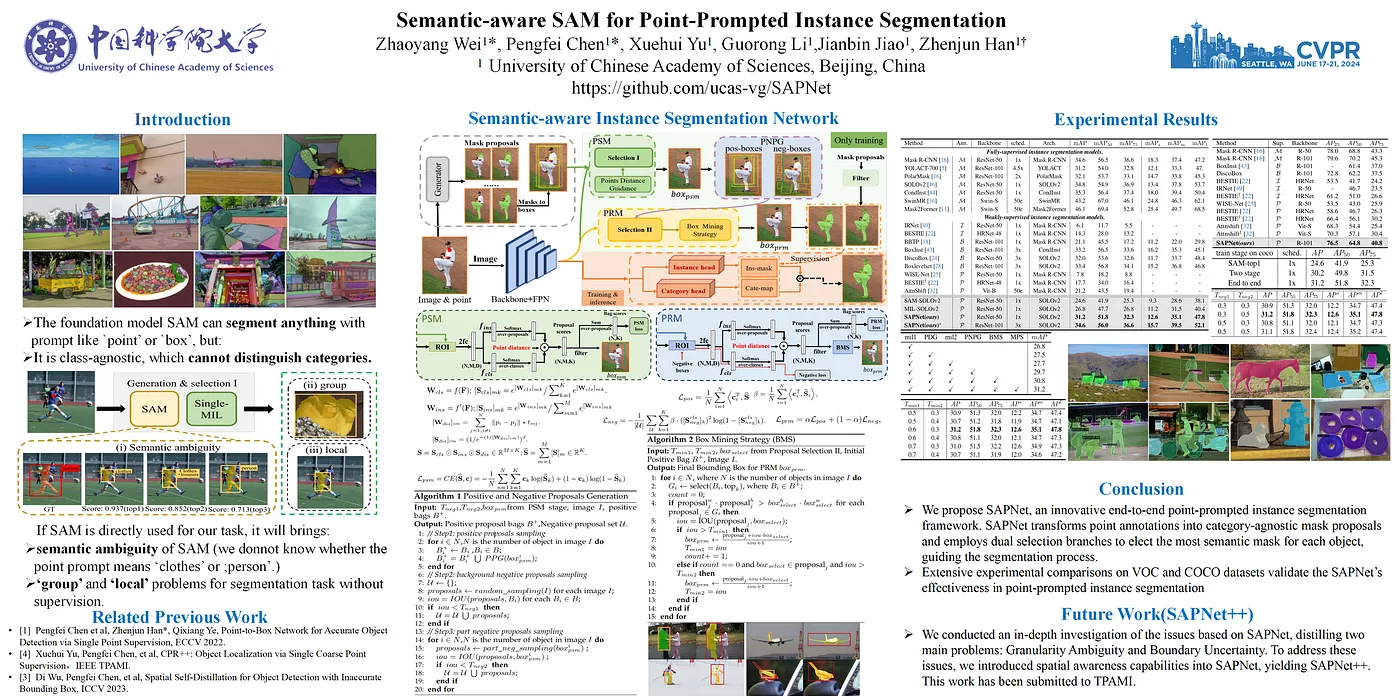

图6. CVPR 2024年海报:用于点提示实例分割的语义感知SAM

论文 : https://arxiv.org/abs/2312.15895

💻 试试它: 访问此GitHub仓库 https://github.com/zhaoyangwei123/SAPNet

💡 主要创新点: 开发了语义理解实例分割网络(SAPNet),该网络结合了多实例学习(MIL)和视觉基础模型(如SAM [5])并使用点提示。SAPNet 通过策略性地选择代表性掩膜提案并利用点距离引导和框挖掘策略来提升特定类别分割效果。

潜在的应用领域:

- a) 自动驾驶:提高自主驾驶系统中的目标检测和分类,从而做出更优的决策并提高安全性。

- b) 农业监测:提供特定作物或植物的精确识别和分割,利用空中或卫星拍摄的图像进行更好的农业管理和产量预测。

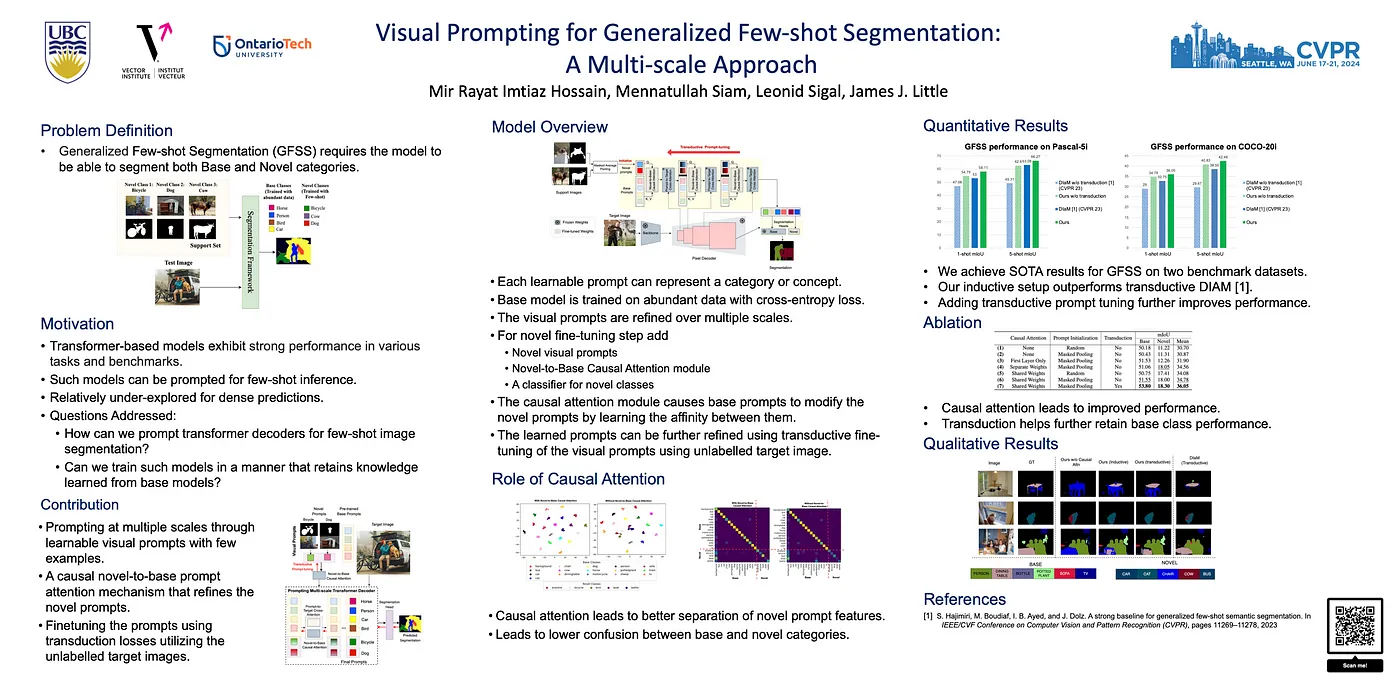

图7. CVPR 2024关于广泛少量样本分割的视觉引导的展示海报

论文 : PDF: https://arxiv.org/pdf/2404.11732.

💻 试试它 : https://github.com/rayat137/VisualPromptGFSS

💡 主要新颖性: 使用学习到的视觉提示和变压器解码器进行通用少样本分割(GFSS)。具体而言,他们引入了新型提示(从少量示例中学习得到)和基础提示(从大量数据中学习得到)之间的单向因果注意力机制来实现通用少样本分割(GFSS)。

可能的应用:

- a) 自动驾驶车辆: 快速适应新物体和道路条件,仅需少量示例,同时保持对常见道路元素的识别性能。

- b) 卫星图像分析: 识别和分割新的土地使用类型和环境变化,仅需少量示例,同时保持对已知地理特征的识别准确性。

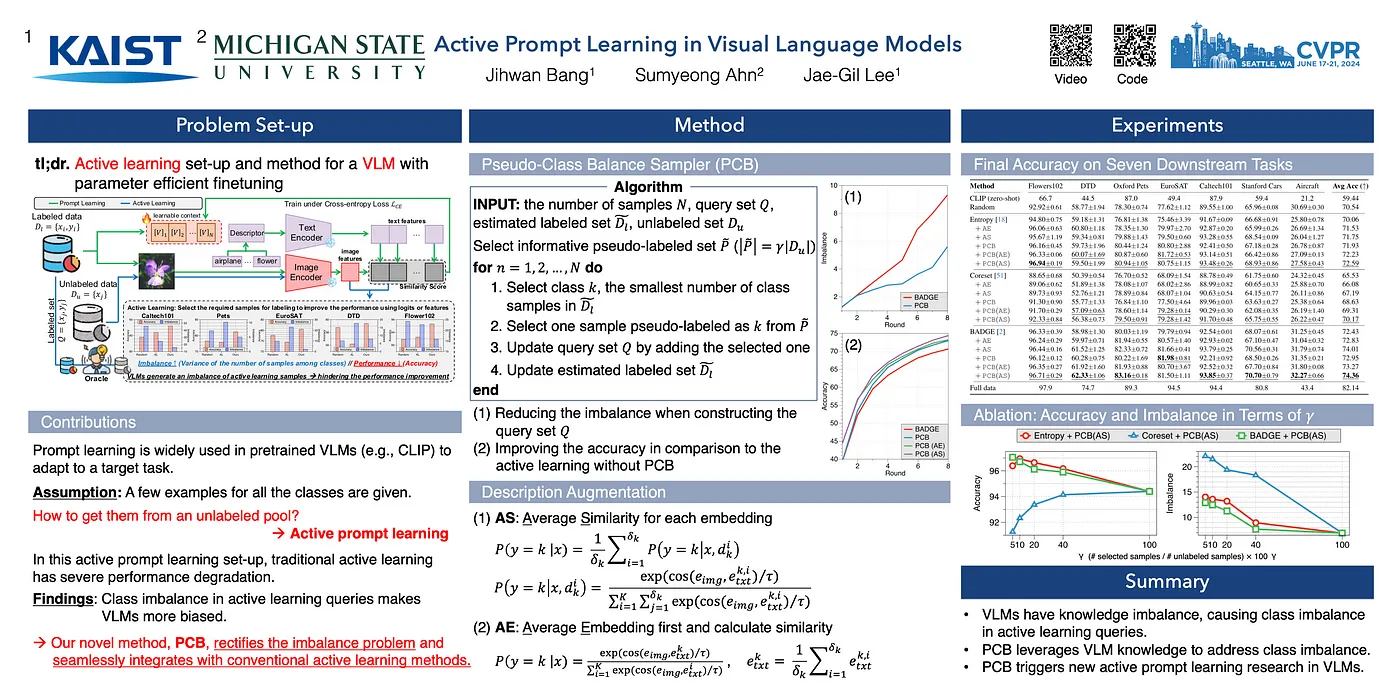

图8. 视觉语言模型中的主动提示的CVPR 2024海报

论文 : PDF:https://arxiv.org/pdf/2311.11178

💻 试试它:https://github.com/kaist-dmlab/pcb

💡 主要创新点: 开发了一种名为PCB的主动学习框架,专门用于预训练视觉语言模型(VLM)的框架。这种方法解决了将VLM适应新任务的挑战,同时大大减少了昂贵标注的需求。

一些应用,

- a) 医学成像: 快速调整视觉大型模型(VLMs),以最少的专家标注量来识别新的疾病模式或异常情况。

- b) 电子商务: 通过有限的手动输入快速提升产品分类和搜索功能,以适应新的产品类别。

正如我们在这篇文章中讨论的,视觉提示技术使我们能够在输入空间中适配基础模型。这很重要,因为这种输入方式充当着人类和模型之间的通用界面。

在视觉领域的可提示的视觉模型可能会改变传统的计算机视觉流程的操作方式。许多这类模型可以被视为将取代传统流程中一些常见环节(比如标注)的基础模块。

在 Tenyks,我们认为这一变革比我们预期的更近。在我们的文章《Computer Vision Pipeline 2.0》中,我们提炼了一些关键见解,解释为什么这一变化是不可避免的。

快速了解 CVPR 2024 的亮点,获取该领域顶尖会议的精华内容在这里:

- 图像和视频搜索及理解 ——视频理解和搜索。

- CVPR 2024 亮点必知 ——具身AI、生成式AI、基础模型和视频理解。

🔥 了解更多关于Segment Anything Model 2 (SAM 2)的精彩内容:

- 新 SAM 2 + GPT-4o — 基础模型的级联:通过视觉提示 — 第一篇

[1] 探索视觉提示以调整大规模模型

图像类比 (2)。点击这里查看: 2

[3], 语言模型可以作为无监督的多任务学习者

[4] 视觉提示

[5] 任意分割

[6] YOLO-World: 实时多词目标检测

作者:何塞·加布里埃尔·伊萨斯·蒙特罗,德米特里·卡赞。

如果你想了解更多关于Tenyks,可以去探索[sandbox](点击这里访问:https://tenyks.docsend.com/view/cyzf9j64wytwgtaj)。

这篇关于CVPR 2024大会前瞻:视觉提示技术将颠覆计算机视觉,基础模型迎来重大变革的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

- 2024-11-19WebSocket入门指南:轻松搭建实时通信应用

- 2024-11-19Nacos安装资料详解:新手入门教程

- 2024-11-19Nacos安装资料:新手入门教程

- 2024-11-19升级 Gerrit 时有哪些注意事项?-icode9专业技术文章分享

- 2024-11-19pnpm是什么?-icode9专业技术文章分享

- 2024-11-19将文件或目录压缩并保留到指定的固定目录怎么实现?-icode9专业技术文章分享

- 2024-11-19使用 tar 命令压缩文件并且过滤掉某些特定的目录?-icode9专业技术文章分享

- 2024-11-18Nacos安装入门教程

- 2024-11-18Nacos安装入门:轻松掌握Nacos服务注册与配置管理

- 2024-11-18Nacos配置中心入门:新手必读教程