在Macbook上本地运行Meta Llama 3 80亿参数模型指南

2024/10/25 21:03:21

本文主要是介绍在Macbook上本地运行Meta Llama 3 80亿参数模型指南,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

部署新的 Meta Llama 3 模型,并在 M1/M2/M3 Pro MacBook 上使用 Ollama 部署 80亿参数的模型。

Ollama 是一个部署开源大型语言模型(LLM)的平台,可轻松地在您的 Mac、Windows 或 Linux 机器上本地部署。在一台配备 16GB 内存的 M1 Pro MacBook 上,整个设置过程大约需要 10 到 15 分钟。设置完成后,模型会在不到 10 秒的时间内启动。

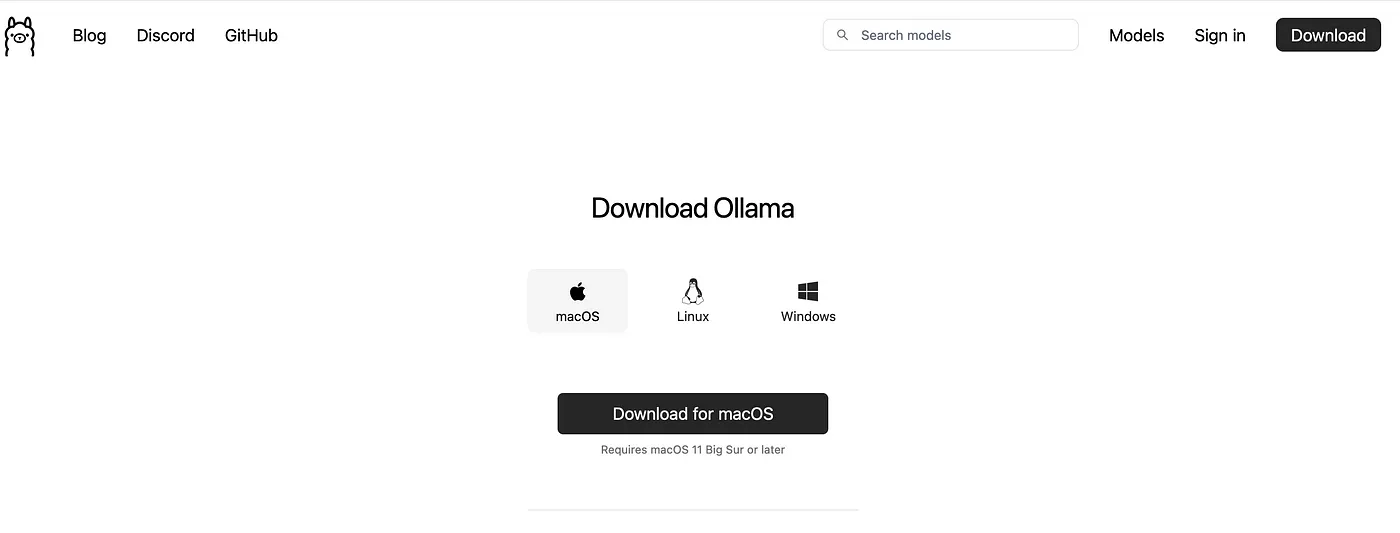

- 去 >> https://ollama.com/download/mac 下载适合您操作系统的软件

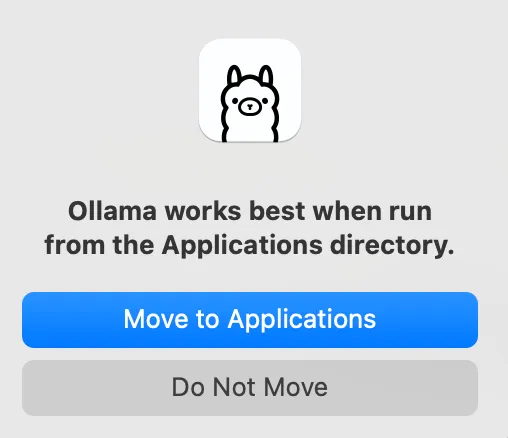

我们下载macOS的zip文件并解压缩它。

2. 打开 Ollama 应用并找到 Ollama 应用运行一下 llama3 命令

下载和构建大约需要10到15分钟,这取决于您的网络带宽。您可以打开 http://localhost:11434/ 来检查Ollama是否正在运行。

如果浏览器显示“Ollama 正在运行中”,那就说明一切正常。

4.. 现在我们来运行Ollama,看看它的推理速度如何

最后,让我们为你的macOS添加一些常用的别名快捷方式,以便你快速启动和停止Ollama

vim ~/.zshrc #在文件中添加以下两行命令 alias ollama_stop='osascript -e "tell application \"Ollama\" to quit"' alias ollama_start='ollama run llama3' #在新的会话中运行以下命令以启动或停止Ollama, ollama_start, ollama_stop,5. 其他模型文件的下载

ollama run dolphin-llama3

ollama run mistral

ollama 运行 codellama:7b-code

6. 评估Llama3性能

git clone https://github.com/shadabshaukat/llm-benchmark.git

cd llm-benchmark

python3.11 -m venv venv

source venv/bin/activate

pip install -r requirements.txt

# 确保运行 'ollama serve',以启动 ollama

python benchmark.py --verbose --prompts "What is the sky blue?"

----------------------------------------------------

平均性能指标:

----------------------------------------------------

dolphin-llama3:latest

Prompt 评估时间: 40.44 t/s

响应时间: 30.13 t/s

总计时间: 30.45 t/s

统计:

Prompt 代币数: 25

响应代币数: 576

模型加载时间: 0.00s

Prompt 评估时间: 0.62s

响应时间: 19.12s

总时间: 19.75s

----------------------------------------------------

开心玩AI吧 :)

这篇关于在Macbook上本地运行Meta Llama 3 80亿参数模型指南的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

- 2024-12-23DevExpress 怎么实现右键菜单(Context Menu)显示中文?-icode9专业技术文章分享

- 2024-12-22怎么通过控制台去看我的页面渲染的内容在哪个文件中呢-icode9专业技术文章分享

- 2024-12-22el-tabs 组件只被引用了一次,但有时会渲染两次是什么原因?-icode9专业技术文章分享

- 2024-12-22wordpress有哪些好的安全插件?-icode9专业技术文章分享

- 2024-12-22wordpress如何查看系统有哪些cron任务?-icode9专业技术文章分享

- 2024-12-21Svg Sprite Icon教程:轻松入门与应用指南

- 2024-12-20Excel数据导出实战:新手必学的简单教程

- 2024-12-20RBAC的权限实战:新手入门教程

- 2024-12-20Svg Sprite Icon实战:从入门到上手的全面指南

- 2024-12-20LCD1602显示模块详解