基于无监督机器学习算法的预测性维护讲解

2024/12/6 21:04:23

本文主要是介绍基于无监督机器学习算法的预测性维护讲解,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

在研究了多年数据科学之后,我发现最有效的预测性维护工具是无监督学习算法。电力行业中的应用尤其明显。

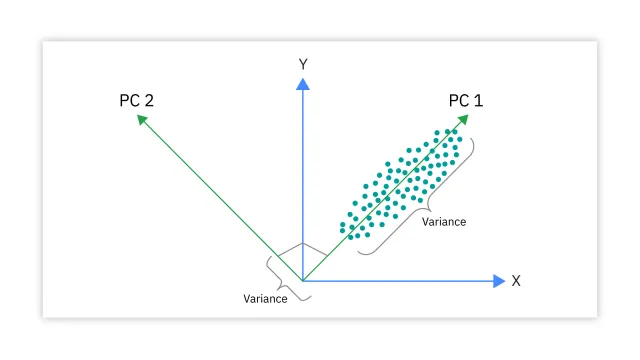

让我从一个最古老且最基本的一种算法说起,即主成分分析(PCA)。卡尔·皮尔森于1901年开发了PCA。你可以在这里找到原文:here。主成分分析擅长于降维,这可以减少模型的复杂性(即维数灾难),消除多重共线性,以及过拟合。此外,PCA还可用于可视化数据,发现趋势、模式或异常值。

PCA 无需标签即可降低维度。也可以进行因子分析和特征提取。PCA 创建新的变量,比如主成分,它们是原始变量的线性组合而成。PCA 可以将高维数据转换为低维子空间的数据集,其中变量更少。PCA 是一种用于数据分析的无监督机器学习技术。了解一些关键术语,例如 特征值、特征向量 和 协方差。我愿意在另一篇 Medium 文章中详细讲解 PCA。

主成分分析 (PCA)

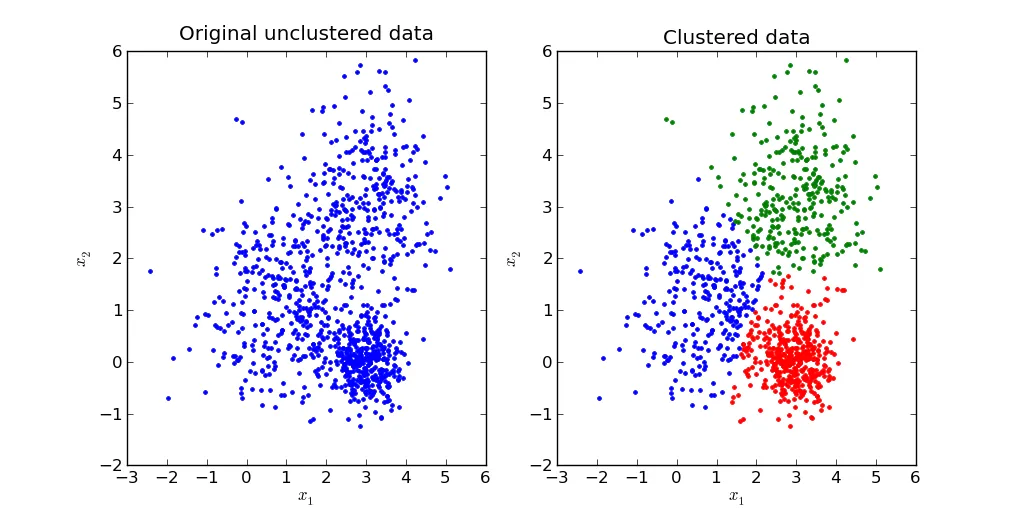

还有另一种基本的无监督学习技术,k-means 聚类。PCA 用来降维,而 k-means 聚类则是根据数据点的相似性来进行分组。它们有着不同的目标和方法。

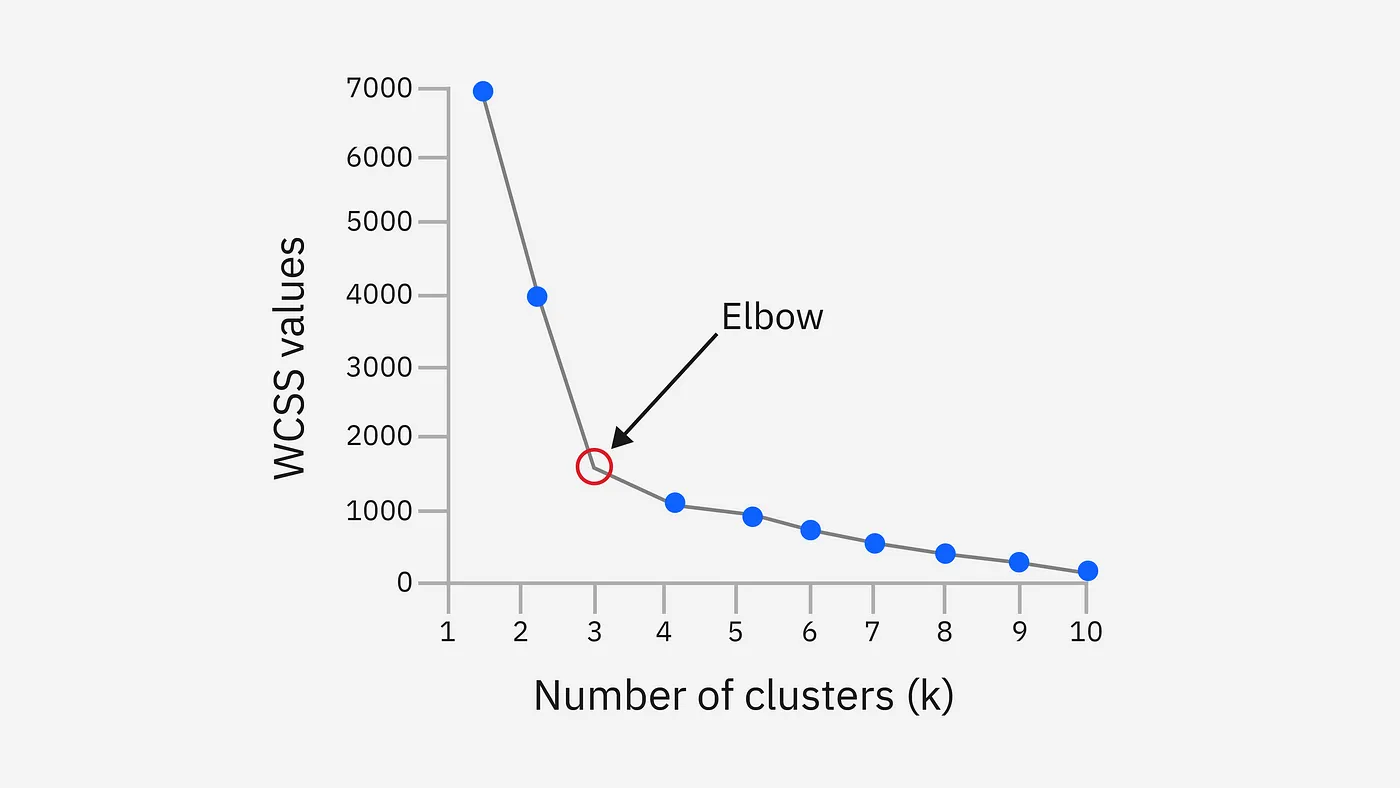

K均值 是一种基于中心点的迭代聚类算法。中心点,即聚类中心,可以是该聚类内所有点的平均值或中位数,具体取决于数据的特性。第一步是初始化 k 个中心点,这里 k 等于选定的数据集中的聚类数量。K-means 算法中常用的术语包括 ‘肘部法则’ 和 ‘聚类内平方和 (WCSS)’。

K-means

K-means的优势是简单、快速、易于扩展。

K-means算法的缺点包括依赖初始参数设置、在特定数据集上可能表现较差、以及离群值的显著影响。

我愿意在另一篇 Medium 博客文章中详细说明 k-means。

肘部法则

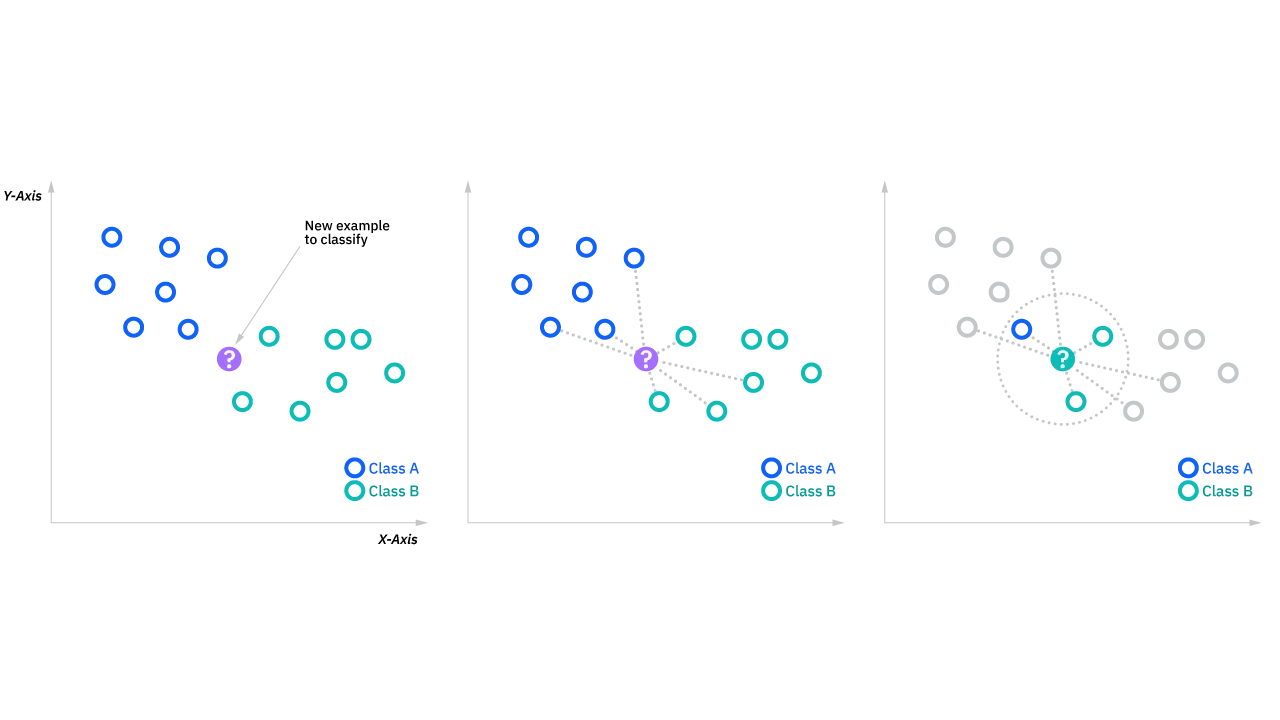

在这里我必须提到K-最近邻(KNN(K近邻算法))算法。这是用于预测性维护中最重要且最常用的算法之一,同时也是机器学习中最受欢迎和最简单的分类和回归分类器。在这个算法中,k值决定了确定特定查询点分类时需要考虑的邻居数量。如果k=1,该实例将被分配给唯一最近邻居的类别。对于回归问题,基本概念与分类问题类似,但在这种情况下,取k个最近邻的平均值来进行预测。KNN的关键概念有多数投票、欧氏距离、曼哈顿距离、明氏距离、汉明距离。

KNN的优点包括易于实现,容易调整,以及超参数较少。

KNN的缺点包括维度灾难、不适合处理大规模数据以及容易过度拟合。

注: 虽然 KNN 是一种监督学习算法,我们还需要注意,诸如 DBSCAN、OPTICS、SOM(sōm) 和 LSH 等算法在聚类之后,使用 KNN 技术进行预测。

我愿意在另一篇文章中详细解释KNN。

KNN

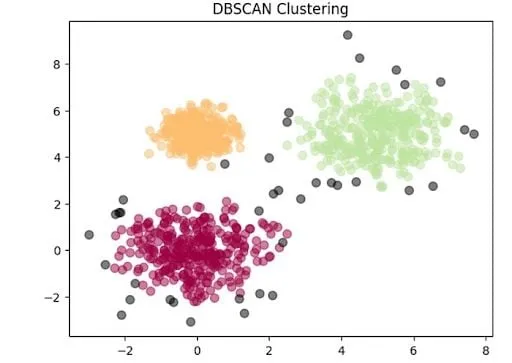

最后一个基础的无监督机器学习算法是基于密度的空间聚类算法(DBSCAN)。它将聚类定义为数据集中点密度较高的区域,而那些远离聚类的点则被视为离群点或噪声。我们的目标是把这些点聚集成紧密的群体。

圆的半径 ε(也叫epsilon)是第一个参数值。

圆的半径 ε(ε 是希腊字母,代表一个小数值) 是第一个参数。最少点数 m(m 为参数) 是参数中的另一个。

DBSCAN 几个关键词有 核心点、非核点、边界点 和 离群值。

DBSCAN 聚类算法

DBSCAN 是一个非常有用的工具,可以用于数据清理和异常值识别。

DBSCAN的优势在于它具有多样性,能够处理噪声,并且无需预先知道最佳聚类数量。

DBSCAN的缺点包括对超参数的选择敏感,在密度差异很大的数据集上表现不佳。

我愿意在另一篇单独的 Medium 文章中详细解释 DBSCAN。

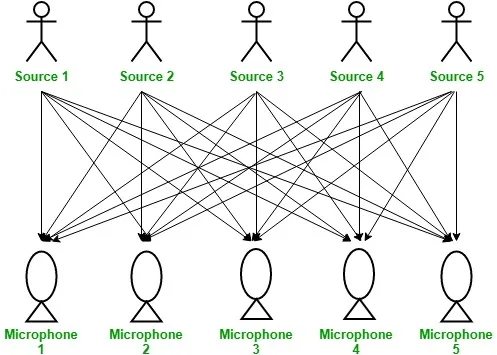

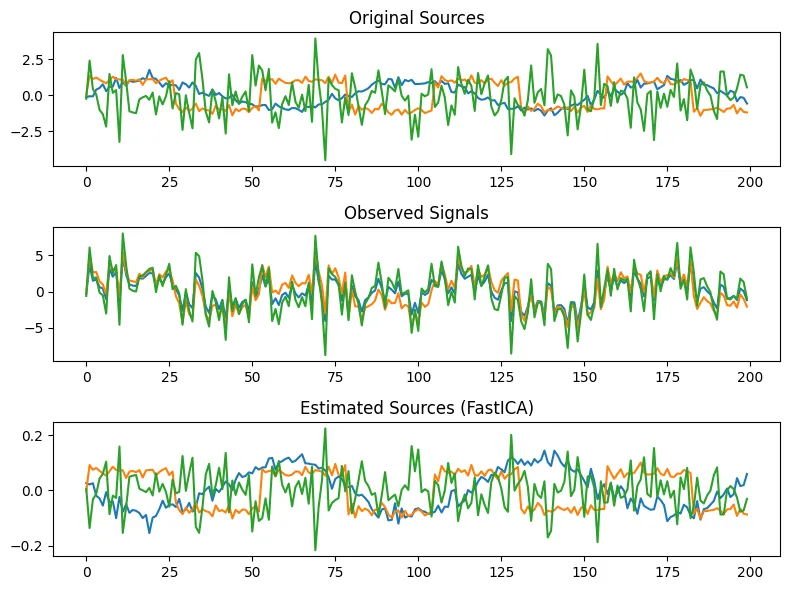

更高级的预测性维护算法独立成分分析(ICA) 是一种用于机器学习中的统计和计算方法,用于将多变量信号拆分为其独立的非高斯信号。ICA 的关键术语是 统计上的独立性,非高斯的分布。

鸡尾酒会上的听觉问题

ICA的优势包括强大的混合信号分离能力、非参数方法和无监督学习技术,这些技术还非常适用于特征提取。

ICA的缺点包括非高斯、非线性混合问题、计算代价高昂以及可能的收敛问题。

PCA(主成分分析)和ICA(独立成分分析)之间有什么区别?

PCA 强调最大化方差并提供正交的成分,而 ICA 则专注于提取统计上独立的成分,即使它们之间存在相关性。因此,ICA 适合用于盲信号分离和信号提取任务等。

我很乐意在另外一篇文章中详细说明这个概念的ICA,而不是在这里赘述。

独立成分分析法(ICA)

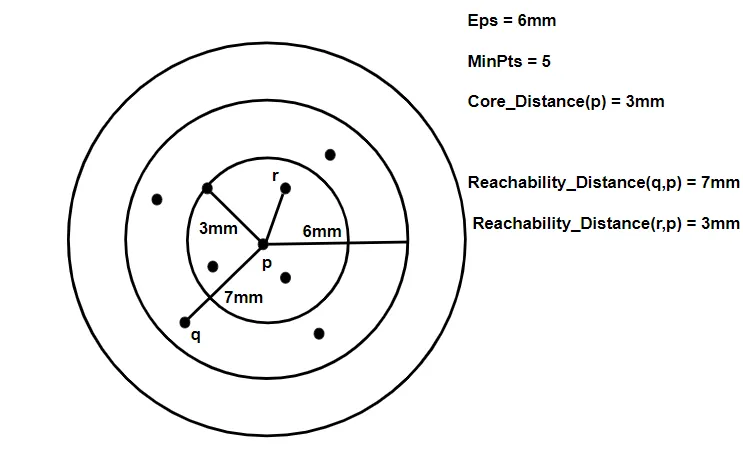

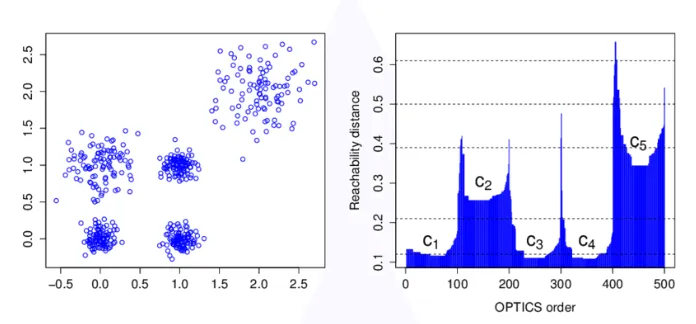

另一种高级算法是 Ordering Points To Identify Cluster Structure (OPTICS)。它在 DBSCAN 的基础上增加了两个术语。它与 DBSCAN 类似,但可以提取不同密度和形状的簇。它在大型高维数据集中识别不同密度的簇方面很有用。OPTICS 算法的关键术语包括 Epsilon、k-最近邻、核心距离、可达距离 和 可达性图(或称为 可达性图)。

光学集群

聚类对比与DBSCAN聚类

OPTICS 聚类技术需要更多的内存,但比 DBSCAN 需要较少的参数设置。OPTICS 比 DBSCAN 更能识别不同大小和形状的聚类。DBSCAN 明确区分核心点和边界点,但不区分噪声点,而 OPTICS 也是如此。OPTICS 的运行时通常更复杂。

我愿意这么做,在另一篇单独的 Medium 文章里详细解释一下光学。

可达性图示

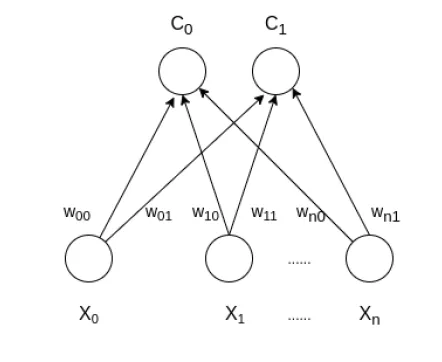

自组织映射(SOM) — Kohonen 映射 是一种受20世纪70年代生物神经模型启发的人工神经网络。SOM 用于聚类和映射(或降低维度)。SOM 有两个层次:输入层和输出层。

关键词包括 欧几里得距离,C个簇,权重,学习率α 在SOM算法中。

我愿意在另一篇 Medium 文章里详细讲讲 SOM 的细节。

SOM

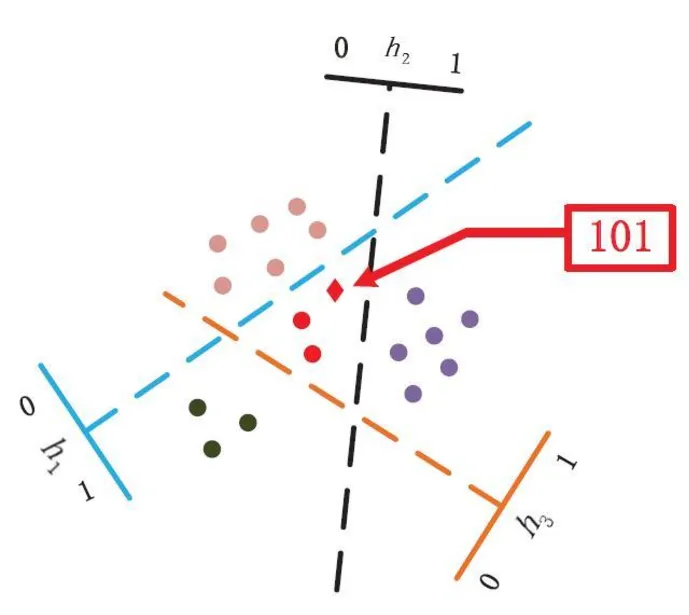

局部敏感哈希(LSH) 可以近似高维数据点之间的相似性,使其成为高效解决最近邻搜索问题的理想方法。LSH 与传统的哈希方法不同,它旨在让相似项之间产生更多碰撞,而不是减少碰撞。LSH 关键词包括哈希函数、最近邻、桶(bucket)和碰撞。

我可以另一篇单独的在 Medium 文章中在解释LSH细节时。

(Note: There's a slight grammatical issue due to the structure suggested. A more natural way to express this would be:)

我可以另写一篇单独的在 Medium 文章中解释LSH的细节。

LSH

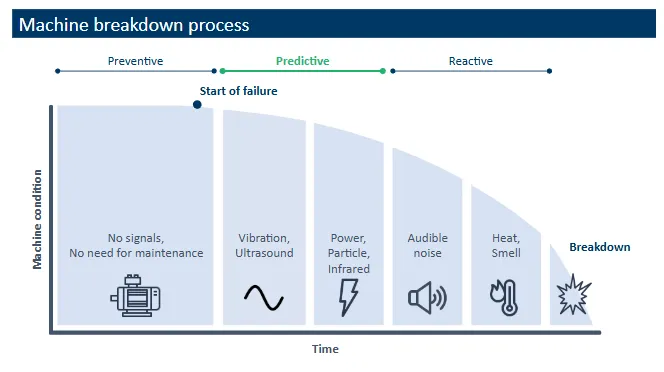

这些算法用于检测异常,并确定哪些特征导致更大的偏差。无监督和半监督学习方法为我们提供了非常强大的工具来及时发现并报告故障。

设备故障处理流程

DBSCAN 是一种用于识别聚类的算法……builtin.com](https://builtin.com/articles/dbscan?source=post_page-----19d4f4dd6040--------------------------------)

链接:https://www.geeksforgeeks.org/ml-independent-component-analysis/?source=post_page-----19d4f4dd6040--------------------------------

这篇关于基于无监督机器学习算法的预测性维护讲解的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

- 2024-12-17机器学习资料入门指南

- 2024-12-06如何用OpenShift流水线打造高效的机器学习运营体系(MLOps)

- 2024-12-03【机器学习(六)】分类和回归任务-LightGBM算法-Sentosa_DSML社区版

- 2024-12-0210个必须使用的机器学习API,为高级分析助力

- 2024-12-01【机器学习(五)】分类和回归任务-AdaBoost算法-Sentosa_DSML社区版

- 2024-11-28【机器学习(四)】分类和回归任务-梯度提升决策树(GBDT)算法-Sentosa_DSML社区版

- 2024-11-26【机器学习(三)】分类和回归任务-随机森林(Random Forest,RF)算法-Sentosa_DSML社区版

- 2024-11-18机器学习与数据分析的区别

- 2024-10-28机器学习资料入门指南

- 2024-10-25机器学习开发的几大威胁及解决之道