Qwen2-VL-7B-Instruct:一款强大的图文多模态AI模型

2024/12/13 21:03:18

本文主要是介绍Qwen2-VL-7B-Instruct:一款强大的图文多模态AI模型,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

展示了多模态AI的强大,结合了视觉和文本处理,Qwen2-VL-7B-Instruct 在描述图像、回答关于视觉的问题以及理解视频等棘手任务中表现出色。阿里达摩院创建了这一模型,即Qwen2-VL-7B-Instruct,以在这些复杂任务中展现其卓越能力。

它可以处理静态图像,也能处理动态图像,同时还能够理解语言指令。这让 Qwen2-VL-7B 在这一领域中表现出色。

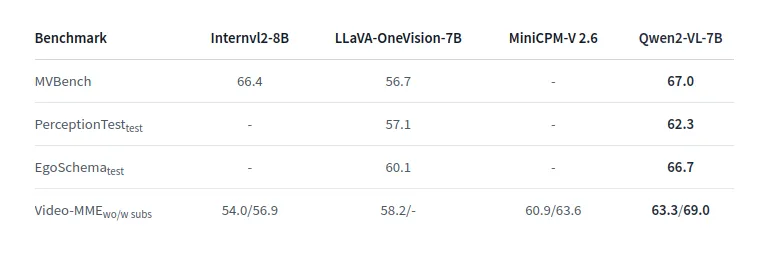

- 高级图像理解: Qwen2-VL 在处理不同比例和分辨率的图像时表现出色,因为它能很好地扩展图像的维度。它在多个视觉理解基准测试(如 MathVista、DocVQA、RealWorldQA、MTVQA)中表现出色,打破了视觉丰富内容难以理解的刻板印象。

- 额外的视频理解: 该模型能够处理二十分钟或更长的视频,从而使基于视频的问题回答、以视频为中心的对话,甚至视频内容生成更加高效。因此,像多媒体内容分析或内容就绪视频创建这样的复杂任务,都可以通过该模型轻松完成。

- 设备操作的自主代理: 这些特性使 Qwen2-VL 能够嵌入手机和机器人等设备,使其变得智能且能够进行推理和决策。通过内化图像输入和文本指令,它适用于机器人、物联网和智能家居设备的自主功能。

- 来自不同多语言国家的文本: Qwen2-VL 对所有人来说都非常有用,因为它提供了多种语言的文本理解能力。除了英语和中文,它还可以识别日语、韩语、阿拉伯语、越南语以及多种欧洲语言的书面文本。

模型结构

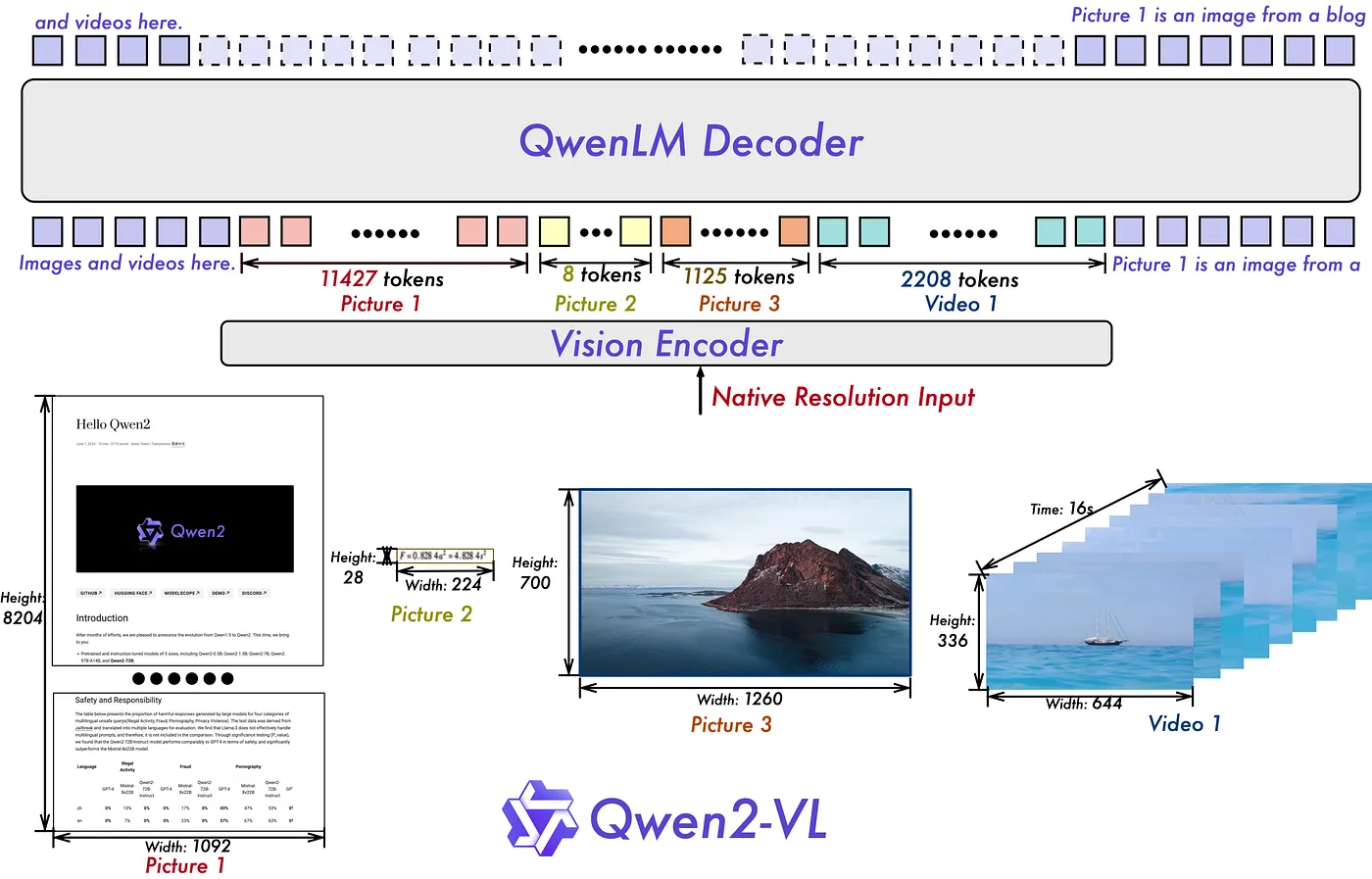

展示的架构是Qwen2-VL,这是一款复杂的视觉语言模型(VLM),设计用于处理图像、视频和文本等多模态输入。下面让我们来看看模型架构的分解。

- 视觉处理单元: 这个组件处理原始分辨率下的视觉内容,包括图像和视频。模型可以处理各种大小的输入,如图片1、图片2、图片3和视频1,因此,对图像和视频内容的理解更加透彻。每个视觉输入都被视为一组有序的标记序列,作为解码器的输入。

模型架构页面(点击访问)

- QwenLM 解码器: 解码器输出的是视觉编码器产生的图像和视频序列,这些序列以 token 形式表示。该架构展示了每个视觉输入(例如,由 11427 种 token 组成的图片 1,8 个 token 的图片 2,2208 个 token 的视频 1)是如何被分割成 token,并输入以生成输出或响应。不同的 token 对应图像的不同部分或视频的不同时间点,解码器将这些 token 中的信息分析融入文本中。

- 动态分辨率处理能力: Qwen2-VL 引入了处理任何分辨率图像的能力,动态调整生成的视觉标记数量。这种方法模仿人类的视觉感知,提供了处理各种尺寸图像时更大的灵活性和适应性,而不牺牲细节或准确性。

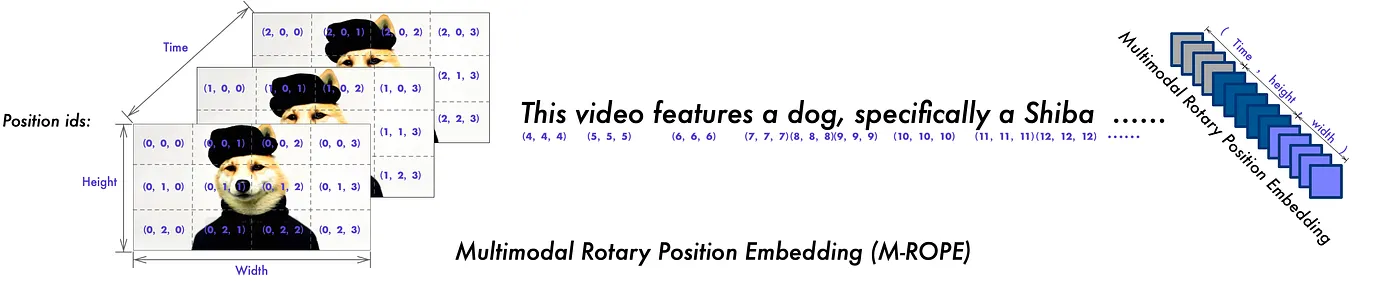

- 多模态旋转位置嵌入(M-ROPE): 通过将位置嵌入分解成不同的部分,Qwen2-VL 能够捕获多个维度的信息——1D 用于文本,2D 用于图像,3D 用于视频。这种分解显著增强了其处理复杂多模态输入的能力,使模型能够更有效地理解和关联空间和时间信息。

Qwen2-VL-7B-Instruct在视觉任务领域非常灵活和有能力,然而,以下限制需要注意——可能会影响潜在的积极结果:

- 不具备音频处理能力: 该模型不支持对音频内容的解释或处理,因此将其多模态范围限制在视觉和文本形式上。

- 过时的数据集: — 用于训练的图像数据集仅更新到2023年6月,这意味着在此之后提供的任何额外信息或图像可能无法被系统很好地整合。

- 计数不准确: 在复杂的空间环境中,包含多个不同场景,该模型在分析和确定数量时,可能会持续面临更准确呈现的挑战。

- 空间推理能力较弱: 该模型在三维空间推理方面表现出困难,特别是在确定物体在空间中的相对位置时。这使得它在需要精确空间理解的任务上表现较差,例如推断深度或方向。

点击链接关注我领英上的动态:

这篇关于Qwen2-VL-7B-Instruct:一款强大的图文多模态AI模型的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

- 2024-12-21Svg Sprite Icon教程:轻松入门与应用指南

- 2024-12-20Excel数据导出实战:新手必学的简单教程

- 2024-12-20RBAC的权限实战:新手入门教程

- 2024-12-20Svg Sprite Icon实战:从入门到上手的全面指南

- 2024-12-20LCD1602显示模块详解

- 2024-12-20利用Gemini构建处理各种PDF文档的Document AI管道

- 2024-12-20在 uni-app 中怎么实现 WebSocket 的连接、消息发送和接收?-icode9专业技术文章分享

- 2024-12-20indices.breaker.request.limit 默认是多少?-icode9专业技术文章分享

- 2024-12-20怎么查看 Elasticsearch 的内存占用情况?-icode9专业技术文章分享

- 2024-12-20查看es 占用内存的进程有哪些方法?-icode9专业技术文章分享