2030年,这将是科技界最重要的技能。

2024/12/20 21:04:11

本文主要是介绍2030年,这将是科技界最重要的技能。,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

戴里奥·阿莫德伊(Dario Amodei)最近在莱克斯·弗里德曼的播客上出现,他是 Anthropic 的首席执行官。

Anthropic 是 Claude 的开发公司,Claude 是当今最先进的商业LLM之一。

他提到了几件事,不过今天我们特别要聊一聊——未来的人工智能会是怎样的?

我们将从探讨我们如何达到当前的大规模语言模型(LLM)的状态开始。接下来,我们将讨论Amodei的预测,对未来几年世界将如何发展的预测。

最后,我们将探讨为什么 机械可解释性 将成为未来最重要的研究方向,了解它是什么以及它为什么如此重要。

近几年来,人工智能取得了迅速的进步。这一切始于《注意力就是你所需要的一切》这篇论文中介绍的Transformer,让我们能够创建比之前的任何模型都要强大得多的模型。

引领我们进入ChatGPT时代的最重要认识之一,就是这种“规模效应假设”。

根据缩放假说,当Transformer模型变大时,模型对数据的泛化表现也会更好。

简单来说,“模型越大,AI就越聪明,越接近人类”。

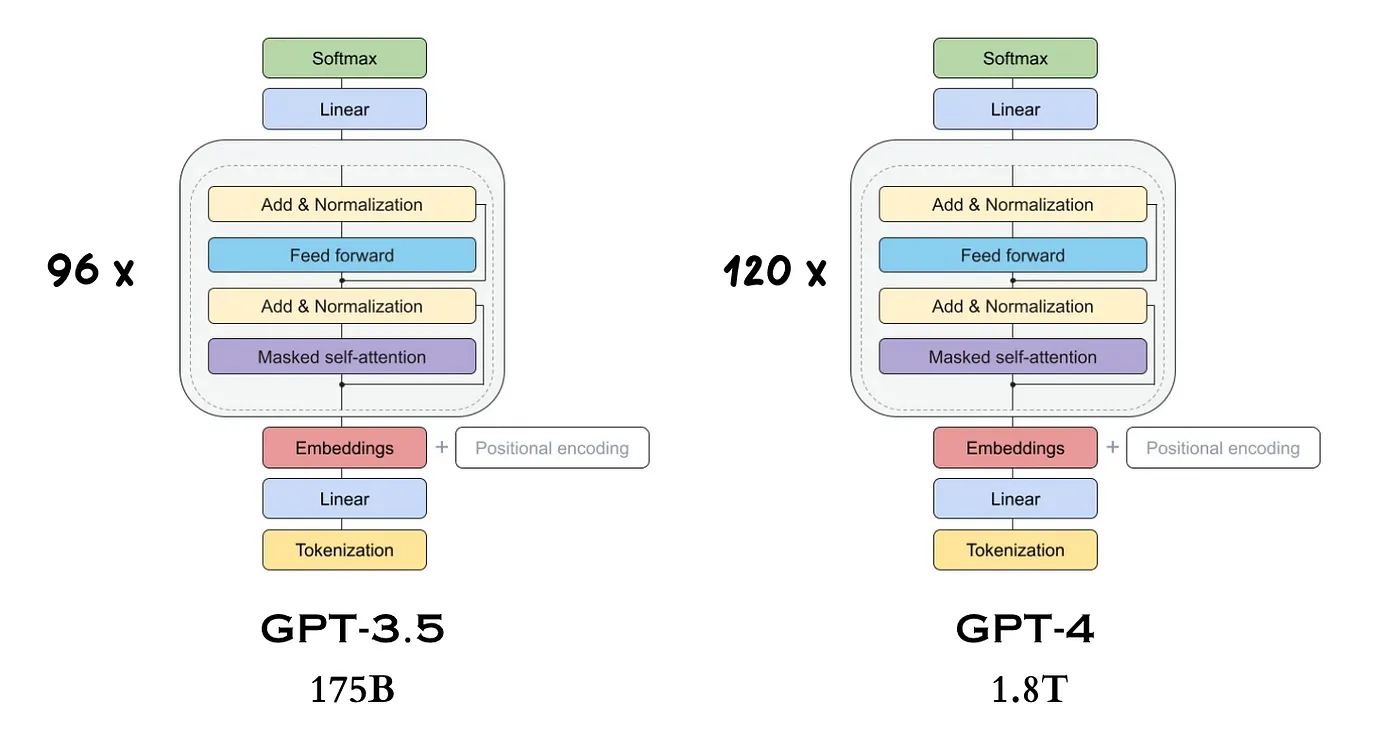

GPT-3.5 和 GPT-4 的参数数量分别为 175B 和 1.8T。随着模型的扩大、层数的增加以及训练数据的增多,模型会变得更智能。

当阿姆德奥积极倡导规模假设时,他还在 OpenAI 工作,这发生在 ChatGPT 横空出世之前很久。这几乎是一个“秘密”——没有其他 AI 公司之前利用过这一想法。训练这样的大型模型需要花费数千万美元,但在阿姆德奥的推动下,OpenAI 即便花费了巨额资金来训练这个巨大的 1750 亿参数模型,最终还是打造出了 GPT-3。

其他人工智能公司很快也跟进起来,看到了开发自家模型的潜力。这其中就包括像这样的大公司如Meta(Llama)、Google(Gemma,Gemini)以及较小的公司如Mistral。

未来的AI会是怎样的?

大多数人认为我们很快就会拥有能够自主思考并执行任务,并且无需任何人类干预的人工智能系统——目前大多数专家都认为我们即将很快实现强人工智能。

阿莫迪有几点预测如下:

- 由于AI研究人员的存在,研究将进展得非常迅速,而生物研究也将加快到足以在未来的100年内最终消灭所有疾病。

- AI能够在较为开放的任务上工作几天或几周,直到完成任务,就像今天公司里的员工被分配任务一样。这与当前的大型语言模型只立即回答封闭性问题形成了对比。

- 如软件工程师这类职业将会因为全球范围内的人工智能软件工程师的存在而变得极其高效。

- 多个AI实例也可以像人类一样协作,共同完成任务,无需任何人类干预即可创造多维度的项目。

一幅未来感的画面,实验室里,机械臂在人工智能系统的操控下自动进行科研。

据阿莫迪估算,一旦人工智能能够进行自主研究,我们就能在5到10年内实现1000年的进展,这将使我们最终进入“技术奇点”——某个未来时刻,技术增长变得不可控且不可逆转。

人工智能会变得非常强大。这不仅能够为世界带来巨大的好处,还可能带来无法估量的伤害。

- 人类目前是地球上最聪明的生物之一。 我们不像大猩猩那样强壮,在身体对抗中我们可能不是它们的对手。是我们的智慧使我们能够统治世界并战胜其他所有动物。

- 如果创造出比人类更聪明的新生物,它“可能”会导致人类的终结。 这就是为什么确保人工智能代理的目标与人类的目标相一致非常重要。

如果我们继续让AI系统变得更加强大,而不确保其目标与人类一致,可能会引发全球性灾难。

人工智能故意制造对人类有害的生物危害物。

因此,机械性可解释性在接下来的几年里会越来越受到重视。

机制解释性(也称为机械解释)背后的思路是揭开AI系统(例如LLM)的黑箱,以理解它们为何表现如此。目前,LLM仍然是一个黑箱,我们不断使它们变得更加强大,但缺乏真正的方法来预测和理解它们为何如此出色。

当阿莫德伊意识到需要时,机械解释性最初便开始了。进行AI安全研究以造福世界。尽管AI有巨大的潜力造福人类,但它也可能带来极大的伤害。如果我们能够最大限度地控制其危害,我们就能确保我们的AI系统对我们的净效益是积极的。

解释性机制只尝试回答两个问题,

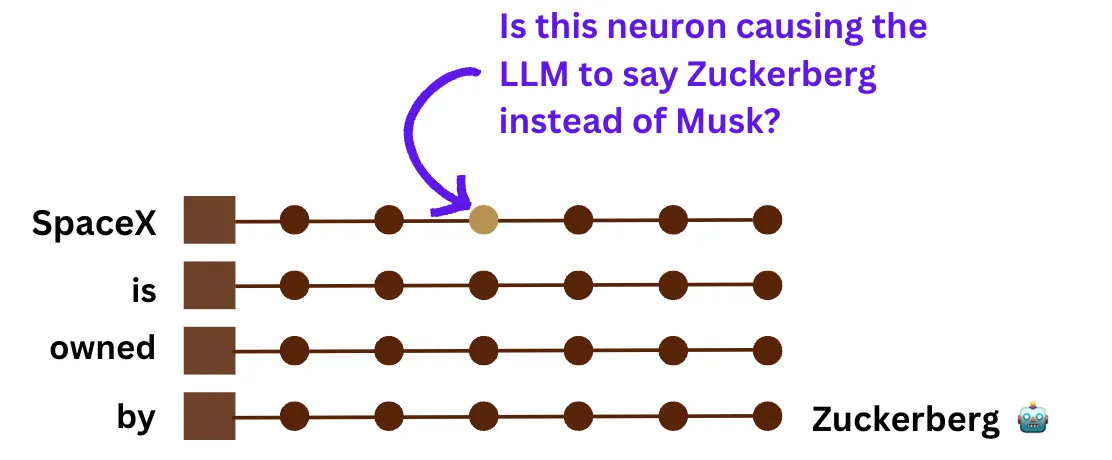

- 我们能否识别出大语言模型(LLM)内部运算与其行为之间的因果关系? 例如:一个LLM是否因为某个特定的神经元向其内部状态中添加了一些数值而“说谎”?

- 我们能否通过调整这些内部运算来改变其行为? 例如:我们能否从LLM的内部状态中减去同样的数值,以使其行为更符合我们的预期?

一个关于机械解释的问题示例:Transformer架构中的特定的神经元是否专门负责产生“扎克伯格”,因此改变这个神经元能否帮助我们输出“埃隆·马斯克”?

阿莫迪表示,接下来的几年将会看到人工智能的巨大增长,并有望实现一种在多种任务上都能表现出色的人工智能。

未来几年技术进步的速度可能会使目前的工作实现完全自动化,新的工作可能就会进入市场。

到2030年,阿莫德说,如果AI不被控制住,可能会给世界带来灾难性后果。

因此,管控人工智能将会成为全球优先事项之一,不仅是为了最大限度地利用人工智能的好处,还要尽量减少它可能对我们造成的负面影响。

这就体现出机械可解释性的重要性了。

今天,多家公司开始建立自己的可解释性团队,而随着人工智能风险逐渐显现,这种趋势将会持续下去。这些团队将致力于保护人类免受人工智能潜在风险的危害,同时确保人工智能最大程度地造福人类。

这就是为什么机械性可解释性将在接下来的几年里成为一个非常重要领域的的原因,

该领域有许多子领域,当前许多研究正在探索不同的方法。如果你想了解更多关于机制可解释性的内容,例如理解机器学习模型如何得出结论的过程,这些博客可能会引起你的兴趣。

这篇博客的内容灵感来自Dario Amodei与Lex Fridman的对话,以及他在博客中的文章《充满爱的机器》"Machines of Loving Grace"。

关注我:领英|推特|主页

这篇关于2030年,这将是科技界最重要的技能。的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

- 2024-12-20自建AI入门:生成模型介绍——GAN和VAE浅析

- 2024-12-20游戏引擎的进化史——从手工编码到超真实画面和人工智能

- 2024-12-20利用大型语言模型构建文本中的知识图谱:从文本到结构化数据的转换指南

- 2024-12-20揭秘百年人工智能:从深度学习到可解释AI

- 2024-12-20复杂RAG(检索增强生成)的入门介绍

- 2024-12-20基于大型语言模型的积木堆叠任务研究

- 2024-12-20从原型到生产:提升大型语言模型准确性的实战经验

- 2024-12-20啥是大模型1

- 2024-12-20英特尔的 Lunar Lake 计划:一场未竟的承诺

- 2024-12-20如何在本地使用Phi-4 GGUF模型:快速入门指南