Apache Spark及分布式计算概览

2025/1/14 21:03:29

本文主要是介绍Apache Spark及分布式计算概览,对大家解决编程问题具有一定的参考价值,需要的程序猿们随着小编来一起学习吧!

Apache Spark 简介(来自 Spark 官网的介绍)

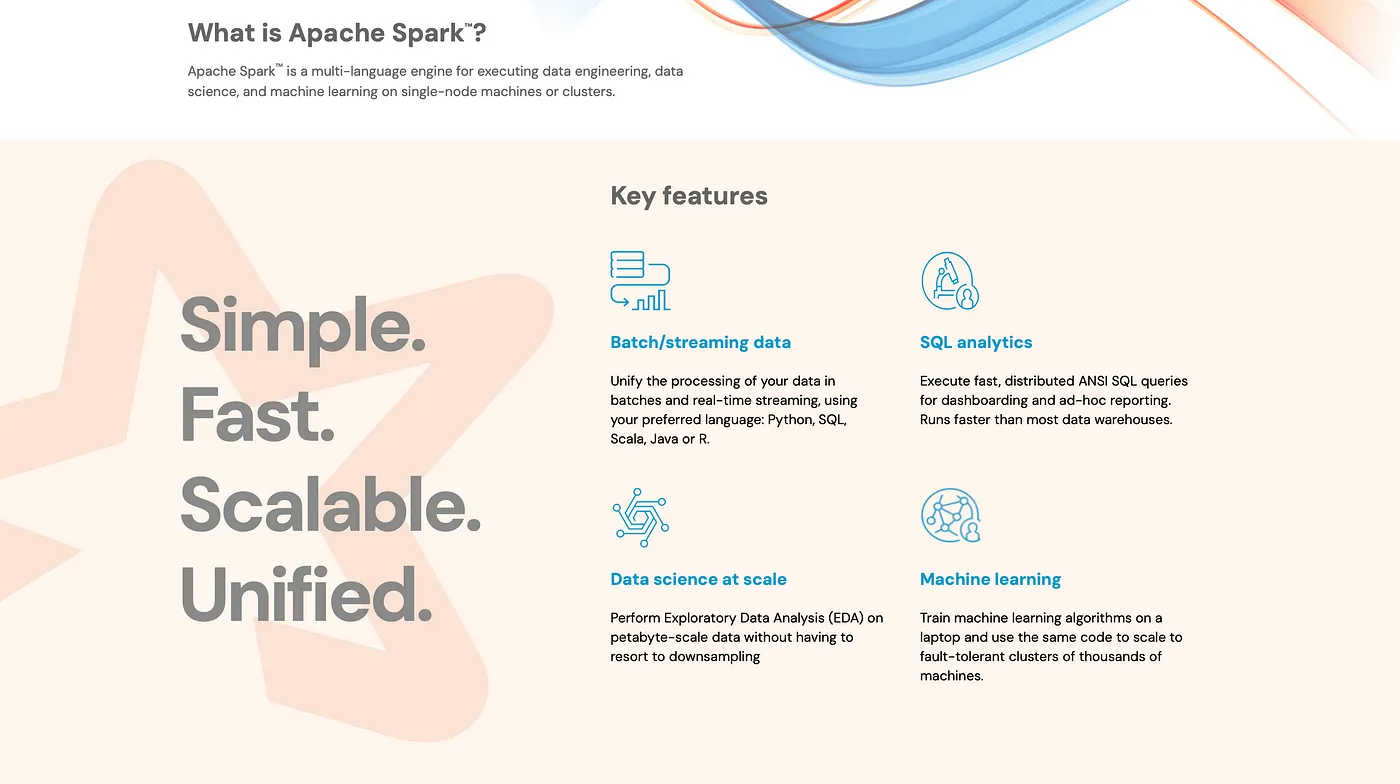

Apache Spark™ 是一个开源的多语言引擎,专为大规模数据处理而设计。它使数据工程师、数据科学家和机器学习从业者可以在单个节点机器或计算机集群上执行强大的数据转换和分析任务。Spark 被优化以提高速度,支持批处理、实时处理、SQL分析、数据科学工作流和机器学习——所有这些功能都在一个统一的平台上统一实现。

Spark的多语言支持意味着您可以使用熟悉的语言(如Python、Scala、SQL、Java和R)处理数据。这种灵活性使Spark成为大数据环境中不可或缺的工具,提供了一个统一的生态系统,支持从数据摄取到高级分析的各个阶段。

如果你急着想动手使用Spark,一个很好的开始是Databricks 社区版。这个免费平台允许你在云端Spark环境中实验,无需自己搭建复杂的环境。你可以用它来实时探索Spark的各种功能。

为了帮助你入门,我们整理了一份详细的指南,内容涉及在Databricks社区版上使用Apache Spark。本文从创建免费账户、配置你的工作区到运行你的第一个Spark程序,都有详细说明。

准备好了吗,要开始您的Spark之旅? 前往Databricks Community Edition网站并跟着我们的指南一步步来,亲自体验一下Spark的强大功能吧。

要理解Spark是如何处理数据的,让我们深入了解一下分布式计算的概念。想象一个任务,比如在一个巨大的图书馆中查找特定页面——也许是在成千上万本书中查找“原子习惯”这个话题的所有提及。如果你尝试独自完成这个任务,将会花费大量时间。然而,如果你有一支团队,每个人可以被分配到特定的区域搜索,任务将会完成得快得多。这就是分布式计算的本质——将一个大任务拆分成更小的部分,并行执行多个部分,然后合并结果。

现在,考虑使用一台计算机与计算机集群进行数据处理之间的区别。一台计算机可以高效地处理较小的任务,但随着数据量的增长,它会变得应接不暇。通过使用计算机集群,每台计算机处理一部分数据,大大缩短了处理时间。Apache Spark 就是为此种并行处理方式设计的,使其能够处理单机无法处理的大型数据集。

Spark 不仅速度快而且灵活,支持不同的数据处理和分析需求。以下是其主要功能的概览:

Spark可以处理批量数据和流数据,从而既能处理实时数据又可以分析静态数据集。比如,在一个金融软件中,Spark可以批量处理历史交易记录,同时处理实时交易流来进行欺诈检测。

Spark 通过 Spark SQL 支持基于 SQL 的查询,使用户能够执行复杂的分析型查询。这一特性使得熟悉 SQL 的数据分析师和工程师可以轻松处理大规模数据集并快速生成见解。

由于其支持大规模数据处理,Spark 允许数据科学家执行复杂分析并利用大规模数据集构建模型,充分利用分布式计算的全部力量。

Spark的MLlib库提供了一套机器学习算法和实用工具,用于分类、回归、聚类和协同过滤等任务,使其成为进行大规模机器学习的强大工具。

为了展示Spark的功能,我们来看一个案例研究,比如Netflix或Amazon Prime Video这样的OTT(流媒体或在线视频)平台,这些平台直接通过互联网向观众提供视频内容。

一个OTT平台收集了大量关于用户行为的数据,包括但不限于用户观看的内容、观看时长、何时暂停或跳过,甚至何时放弃观看某个节目或影片等。这些数据对于以下方面非常重要:

- 向用户推荐相关内容。

- 预测趋势变化基于观看模式。

- 优化内容的分发以提升用户体验为目标。

使用 Apache Spark,OTT平台可以快速高效地处理这些海量数据。以下是Spark的核心特性如何助力更好的决策和洞察:

历史数据分析的批量处理任务

- Spark 可以通过批处理分析历史数据,识别长期趋势,比如最受欢迎的类型、季节性内容偏好或平均观看时间。

- 这些信息可以帮助内容团队根据数据做出内容采购、营销和制作方面的决策。

实时流处理 :

- 使用Spark Streaming,OTT平台可以在用户与内容互动时处理实时数据。例如,Spark可以跟踪用户暂停或停止观看某个节目时的行为,并实时推荐相关内容,以保持用户的兴趣。

- 实时数据还能帮助根据网络状况调整流媒体质量,从而优化内容分发,确保更流畅的观看体验。

机器学习个性化:

- Spark的MLlib可以用于构建推荐系统,根据用户的使用行为、浏览历史以及类似用户的数据来推荐相关的内容。

- 通过大规模地训练和部署机器学习模型,不断优化推荐,从而让平台更个性化,让用户更愿意留下来。

SQL数据分析技术为企业提供洞察

- 通过使用Spark SQL工具,业务分析师可以查询用户参与数据来评估内容发布的成功情况,识别高峰使用时段,或跟踪市场营销活动的表现。

- 例如,SQL 查询可以快速揭示哪些最新发布的内容拥有最高的参与度和观看量,帮助内容团队将注意力集中于表现最佳的类型或主题。

Spark的一个重要优势在于它可以在主要的云平台上运行,使得各种规模的组织无需建立物理基础设施即可使用它。下面是如何在流行的云服务提供商上使用Spark。

- AWS (Amazon Web Services):通过Amazon EMR(Elastic MapReduce),您可以使用Spark处理大规模数据,还可以与Hadoop和HBase等其他大数据工具一起使用。

- GCP (Google Cloud Platform):Google的Dataproc服务提供了托管的Spark集群,允许您根据您的处理需求轻松运行Spark作业,并且可以根据需要灵活扩展或缩小。

- Azure:Azure HDInsight提供了一个具有企业级安全、监控和支持的托管Spark服务。您还可以将Spark与其他Azure服务集成,例如Azure Data Lake和Power BI。

- Databricks:由Spark的原始创建者创立的Databricks提供了一个协作平台,具有优化的Spark集群,使数据工程、数据科学和机器学习领域的Spark工作变得更加容易。

- Cloudera:Cloudera将其Spark作为Cloudera Data Platform的一部分提供,该平台专为混合和多云环境设计,以实现在各种云基础设施上的无缝数据处理。

- Snowflake:虽然Snowflake主要是一个数据仓库,但它与Spark集成,使用户能够在Snowflake数据上执行复杂的数据处理和机器学习任务。

Spark 在这些平台上的可用性意味着用户可以在可扩展、易于管理的环境中利用 Spark 的强大功能,而无需担心硬件或基础设施的问题。

Spark和分布式计算的强大之处远远超出了OTT平台。这里有几个额外的例子供你参考一下:

零售银行业务

- 在银行业,Spark 可用于欺诈检测、交易分析和客户分层,从而实现对数百万笔交易的实时监控和风险管理。

医疗保健:

- 在医疗领域,Spark 可以处理大量患者数据,以支持诊断、治疗建议以及医学研究,从而为更个性化的医疗服务铺平道路。

电商:

- 电子商务平台使用Spark技术来分析购买数据以推荐产品,优化库存管理,并预测市场需求,从而提升客户体验和运营效率。

生产 :

- 在制造中,Spark 可以处理机械设备的传感器数据,预测维护需求并避免设备故障发生,从而提升生产效率并减少停工时间。

Apache Spark 和分布式计算已经改变了组织处理和分析大规模数据集的方法。凭借其在批处理和流数据处理、SQL 分析、数据科学和机器学习方面的强大能力,Spark 使大规模数据驱动的决策成为可能。它在主要云平台(如 AWS、GCP、Azure、Databricks、Cloudera 和 Snowflake)上的可用性使其能够服务于各种规模的公司,进一步推动了大数据分析的普及。

如果你在零售银行、医疗保健或电子商务等领域工作过,不妨思考一下使用Spark进行分布式计算能如何革新你的数据处理方式。Spark提供了可扩展性和实时分析的基础,从个性化推荐到预测性维修,Spark都能支持,革新你的数据处理方式。

你准备好了使用Spark和分布式计算的强大功能了吗?

这篇关于Apache Spark及分布式计算概览的文章就介绍到这儿,希望我们推荐的文章对大家有所帮助,也希望大家多多支持为之网!

- 2025-01-15你可能误会了!用 TypeScript 的正确姿势并不是这样子的

- 2025-01-14成本考量下,开源 CMS 内容管理系统为何脱颖而出

- 2025-01-14用Diffusers结合CivitAI模型、LoRAs和文本反转生成更高质量的图像

- 2025-01-14利用ChatGPT自动构建知识图谱的方法讲解

- 2025-01-14?? 缓存增强生成(CAG):一个崛起的RAG竞争对手?

- 2025-01-14AWS入门第一篇——云基础与EC2实例详解

- 2025-01-14Apache Iceberg:现代数据栈中的“新一代Hadoop”?

- 2025-01-14深入理解 ECMAScript 2024 新特性:Promise.withResolvers

- 2025-01-13SRM vs SCM:企业管理中的差异战略与实践

- 2025-01-12深入理解 ECMAScript 2024 新特性:Map.groupBy() 分组操作